NANDを再定義、HBMを補完するAI用メモリ技術「HBF」:SK hynixは26年1Qに試作発表へ(1/2 ページ)

NANDダイを複数積層して大容量化を図る「高帯域幅フラッシュ(HBF)」は、HBMを置き換えるのではなく補完するAI向けメモリ技術として期待が高まっている。本稿ではその最新動向を紹介する。

AI時代の現在、ChatGPTのような膨大な量のコンピュート/ストレージを消費する大規模モデルがメモリ業界を再形成しつつある中、新しいストレージソリューションによって、AI推論向けのメモリ容量や性能が革命的に変化しようとしている。

HBMとHBFのハイブリッドアーキテクチャで性能2倍以上に

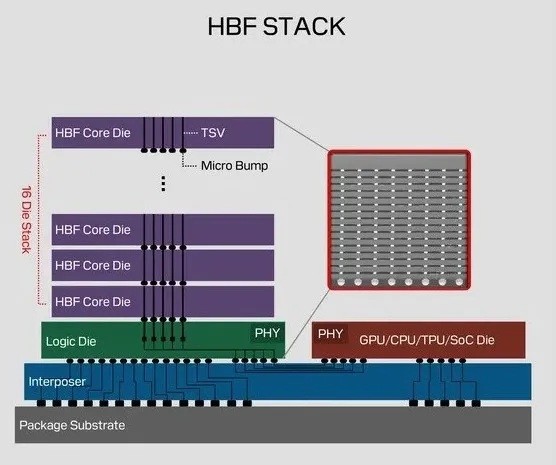

広帯域フラッシュ(HBF:High Bandwidth Flash)は、数百もの3D NANDフラッシュメモリ(以下、NAND)セル層からなるNANDダイを複数積層することで、これまでにないメモリ容量を実現する技術だ。ただし、厳しいエンジニアリング上の課題も伴う。高帯域幅メモリ(HBM)がDRAMチップを積層してメモリ帯域幅を最大化するのに対し、HBFは3D NANDアレイを積層して並列I/O性能を劇的に高める。

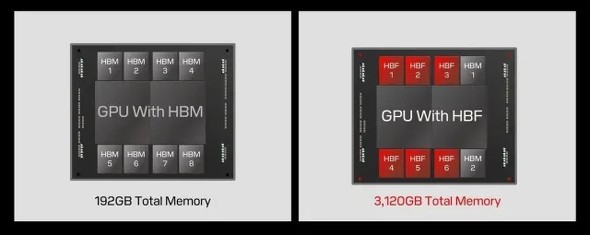

SK hynixは最近、IEEEの論文誌の中で、計算を担うGPUと一緒にHBMとHBFを両方配置するという、ハイブリッドメモリアーキテクチャを発表した。NVIDIAの最新GPU「Blackwell(B200)」と、8個のHBM3Eスタックおよび8個のHBFスタックを組み合わせたものだ。シミュレーションテストでは、HBMだけを配置した場合と比べて、1ワット当たりの性能が約2.69倍向上することが明らかになったという。

HBM大手のSK hynixは、2026年第1四半期にHBFの試作バージョンを発表する予定だという。Samsung Electronics(以下、Samsung)とSK hynixは、Sandiskと提携し、HBF技術の研究開発を商用化へと迅速に移行させ、標準化を目指している。AIワークロードが着実に増大していることを受け、HBFの商用化は予想以上に早く実現するのではないかと期待されている。

Sandiskは、2026年後半にHBFのサンプル出荷を予定していて、AI推論対応の最初のHBFデバイスは2027年初めに登場する見込みだ。同じくSamsungとSK hynixも、2027年中のHBF製品商用化を目指しているという。

HBMのコンセプトを採用、AI向けに「再設計」されたNAND

HBFは、かつてHBMで採用されていた先進パッケージング/インターコネクト技術を、3D NANDフラッシュと組み合わせることで、ハイエンドメモリに近いデータ伝送速度で大容量かつ低コストのフラッシュメモリを提供するという、実に巧みなアーキテクチャイノベーションだ。

何よりもまず、HBMの設計コンセプトを採用することで、複数のNANDフラッシュチップを高密度で垂直積層している。これによって、メモリデバイス内部のデータ伝送パスを短縮し、集積密度を高め、広帯域幅の実現に向けた土台を構築できる。

そして2つ目に、HBF設計のさらに重要な側面として、並列サブアレイアーキテクチャがある。フラッシュメモリのコア構造を数多くのストレージサブアレイに分割し、独立して並列動作させることが可能だ。そのため、同時にデータの読み書きが可能なチャンネル数が限られている既存NANDフラッシュとは異なり、各サブアレイにはそれぞれ独立した読み書きチャンネルが存在する。

このためHBFは、推論のような読み出し中心のタスクに向けた高性能ストレージソリューションとなる。ただし、HBFは読み出しサイクルは無制限な一方で、書き込みサイクルは約10万回に制限されている。このため、AIソフトウェアを読み出し中心のオペレーション向けに最適化する必要がある。

HBFは、HBMのような超低レイテンシや極端な書き込み速度は達成できないが、かなりの低コストではるかに大きな容量を提供できる。さらに、大量データへの高速読み出しアクセスが必要とされる設計向けに、既存のSSDと比べて桁違いに高い帯域幅を実現できる。

つまり、HBFはHBMを置き換えるのではなく、「メモリの壁」として広く知られている計算/メモリのギャップへの対応を強力に補完する製品だといえる。NANDフラッシュを融合して単一スタックでDRAM並みの帯域幅を実現することで、別の角度からAIメモリの課題に取り組んでいるのだ。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング