感情とIoTを融合させた新しいサービスモデルの提案:JASA発IoT通信(6)(2/6 ページ)

感情とIoTを融合させた「エモーションドリブンサービスモデル」の提案

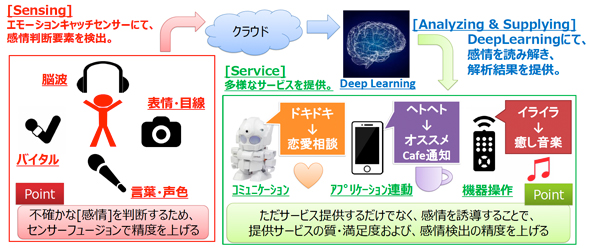

エモーションWGでは、感情とIoTを融合させた「エモーションドリブンサービスモデル」を提案する。下記の図は、エモーションドリブンサービスモデルを実現するためのシステム構成図である。

Sensing

「Sensing」部分では、さまざまなセンサーでエモーションを識別するためのデータを取得する。エモーションを識別するための要素を検出するセンサー(以下エモーションキャッチセンサー)は、脳波センサーやカメラセンサー、バイタルセンサー、マイクセンサーなど、多様な種類のセンサーが想定される。

取得されるデータは、脳波の生データや、画像データ、バイタルデータ、音声データなどであり、取得されたデータから直接感情を識別できるわけではない。取得されたデータから感情を識別するための解析、分析が必要になる。

Analyzing & Supplying

「Analyzing & Supplying」部分では、エモーションキャッチセンサーで取得されたデータを解析し感情識別を行い、識別結果を提供する。感情を識別する解析処理は、取得されたデータをクラウドに送信し、クラウド側で行うことを想定している。識別のアルゴリズムは、取得されたデータのしきい値によって決定するような単純なアルゴリズムで感情を識別できることもあれば、ディープラーニング(深層学習)を利用し感情の識別を行うようなことも考えられる。

また、単純なアルゴリズムで感情を識別できる場合や、クラウド側で学習した学習済みのモデルをエッジ側で利用し、エッジ側で感情を識別できる場合は、クラウドを利用しないというシステム構成も考えられる。

Service

「Service」部分では、クラウド側で識別された感情をトリガーにさまざまなサービスを提供する。サービスは、コミュニケーションロボットやスマホのアプリ、情報家電機器などさまざまなものが考えられる。

例えば、図にあるようにコミュニケーションロボットが人間の感情を判断できれば、チャットポッドとの会話が画一的なものではなく、使用しているユーザーにあった応答ができる可能性がある。また、疲れていることを識別し、スマホにお勧めのカフェの通知やマッサージの広告が通知されれば、集客力高い広告になる可能性がある。作業中のイライラを検知し、作業中のBGMを癒し系の音楽に自動的に切り替えることで、作業効率が下がらない可能性がある。これらの例のように、感情を識別することができ、システムに組み込むことができると、いろいろなサービスモデルが考えられるようになる。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- TIがSilicon Labsを75億ドルで買収する理由

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか