AWSがHabana「Gaudi」搭載のEC2インスタンス提供へ:自社開発の学習用チップも発表

Amazon Web Services(AWS)は、AWSのクラウドサービスに用いられるHabana Labs製AI(人工知能)トレーニング用チップ「Gaudi」ベースのEC2インスタンスを提供する。これは、Intel傘下の新興企業であるHabanaにとって大きな勝利といえる。

Amazon Web Services(AWS)は、AWSのクラウドサービスに用いられるHabana Labs(以下、Habana)製AI(人工知能)トレーニング用チップ「Gaudi」ベースのEC2インスタンスを提供する。これは、Intel傘下の新興企業であるHabanaにとって大きな勝利といえる。AWSでCEOを務めるAndy Jassy氏は、同社主催のカンファレンス「re:Invent」(2020年12月1日[米国時間])の基調講演で、AWSが独自のAIトレーニングチップ「Trainium」を開発したことも発表した。

クラウドプロバイダー各社はこれまで、新たなコンピュータアーキテクチャを用いたサードパーティー製チップへの投資については慎重な姿勢を示し、代わりに独自の専用プロセッサ(Googleの「TPU」、Baiduの「Kunlun」、Alibabaの「Hanguang」、Amazonの「Inferentia」など)を開発する傾向にあった。

例外として、Microsoftのクラウド「Azure」で利用可能なチップ「Graphcore」があるが、“マシンラーニングの限界を押し上げている顧客”を優先する形で提供されている。また、サービスプロバイダーであるNimbixのアクセラレータ「Groq」もあるが、こちらも選ばれた一部の顧客にのみ提供されている。そのため、現在のクラウド業界において、サードパーティーのコンピュータアーキテクチャが採用されるケースは、今回のAWSによるGaudi採用がおよそ初めてではないか。

Jassy氏は基調講演の中で、AWSの目的はAIトレーニングのワークロードに関してGPUに比べより良い価格/性能の選択肢を提供することだと述べた。また、HabanaのGaudiアクセラレーターは顧客によるコスト削減に寄与すると主張した。AWSの内部テストでは、HabanaのGaudiをベースにしたEC2インスタンスにおける価格/性能基準は、既存のGPUベースのEC2インスタンスに比べ最大40%向上したという(AI関連の処理を行っている場合で比較)

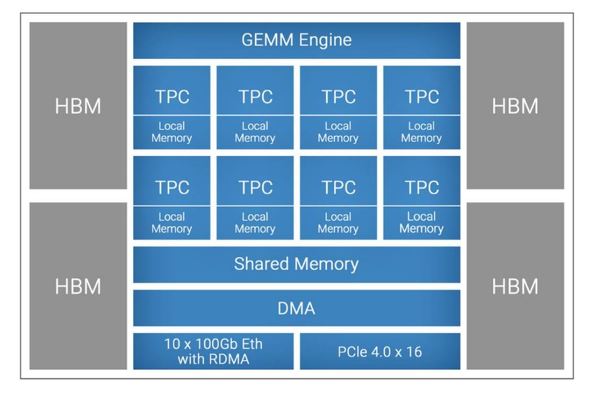

Intel傘下のHabana Labsは、イスラエル・テルアビブを拠点とする新興企業である。2019年に発表された同社製のAIトレーニング用チップ「Gaudi」は、8個のVLIW SIMD(Very Long Instruction Word, Single Instruction Multiple Data)ベクタープロセッサコアを有する。同社はこのコアをTPU(Tensor Processor Core)と呼んでいる。加えて、32GBのHBM2(High Bandwidth Memory, Second Generation)メモリを搭載している。また、Gaudiは、非常に大規模なシステムへのスケーリングに向けて、オンチップのRoCE(Remote Direct Memory Access over Converged Ethernet)通信機能も備えている。

AWSは2021年上半期にGaudiベースのEC2インスタンスを提供する予定である。Gaudiを搭載した8枚のカード(冒頭の画像)を格納したEC2インスタンスはそれぞれ、TensorFlow上で行うResNet-50のモデルの学習(トレーニング)において、1秒当たり約1万2000枚の画像を処理できるとする。

Habanaによると、次世代バージョンの7nmのGaudiは現在開発中だという。

Jassy氏は、AWS独自のトレーニング用チップ「Trainium」も発表した。AIトレーニングにかかるコストを、Habanaのチップを使う時よりも、さらに低くすることを目指すという。Jassy氏は詳細については明らかにしなかったものの、AWSがクラウドでのトレーニングに向けて最も低いコストでTrainiumベースのインスタンスを提供する計画であることを示唆した。また、各インスタンスでは極めて高いパフォーマンス(TFLOPS)を実現できる見込みだという。Trainiumベースのインスタンスは2021年に投入される予定だ。

【翻訳:青山麻由子、編集:EE Times Japan】

関連記事

中国は本当にAI先進国なのか

中国は本当にAI先進国なのか

米国対中国のAI(人工知能)バトルは、どちらが勝者なのか。これはよく聞かれる質問だが、正しく答えられていないことがあまりにも多い。米国では、「AI技術では中国がリードしている」と広く信じられている。しかし、経済学者のDieter Ernst氏は、最近発表した中国のAIチップに関する研究論文の中で、その考えに異議を申し立てている。 脳型コンピュータはAIチップと競合するのか?

脳型コンピュータはAIチップと競合するのか?

新しいニューロモーフィックチップは、同様に最先端の分野であるAI(人工知能)アクセラレーターは、“競合”となるのか。ニューロモーフィックチップやAIアクセラレーターを開発する企業のCEOに、見解を聞いた。 IntelがHabana Labsを買収、Nervana製品の立ち位置は?

IntelがHabana Labsを買収、Nervana製品の立ち位置は?

Intelは2019年12月16日(米国時間)、AIアクセラレーター関連の新興企業であるイスラエルのHabana Labs(以下、Habana)を約20億米ドルで買収したと発表した。これは、驚くべき動きである。Habanaは、Nervanaの競合だからだ。 AIチップ新興企業に成熟の兆し

AIチップ新興企業に成熟の兆し

ここ数年の間、AI(人工知能)チップ新興企業の“カンブリア爆発”(一気に出現すること)について書かれた記事が多くみられるようになった。初期に登場した一部の企業は、自社のAIチップを搭載したモジュール/カードなどを広く提供することによって、実世界においてデザインウィンを獲得したり、世界的な流通チャネルを構築するなど、成熟しつつあるようだ。 AIチップ市場、2026年まで成長率40%で伸びる

AIチップ市場、2026年まで成長率40%で伸びる

AIチップセット市場が、約40%の年平均成長率で成長を遂げている。大量の複雑なデータセットの存在や、顧客企業が性急に推進してきた商用アプリケーションの増加、深層学習やニューラルネットワークの幅広い普及などが後押しとなったのではないかと見られている。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- TIがSilicon Labsを75億ドルで買収する理由

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか