繊細な力加減を持つロボットで「職人技」も再現――リアルハプティクス:モーションリブがデモ(1/2 ページ)

慶応義塾大学発のベンチャー企業であるモーションリブは、微細なチカラ加減を制御する技術「リアルハプティクス」の研究開発/提供を手掛ける。同社は「ロボットがヒトのように動き、人手不足が解消された世界を実現」を目指しているという。【修正あり】

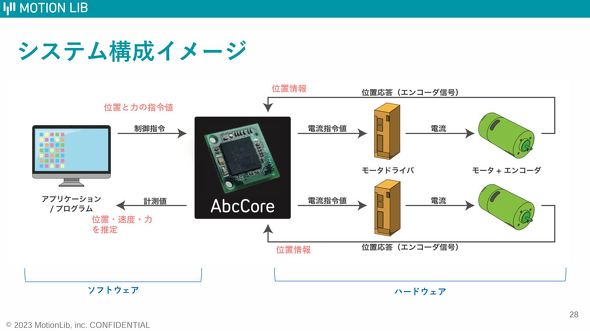

モーションリブは、慶応義塾大学が開発した力触覚制御技術「リアルハプティクス」を実現する力感触制御ICチップ「AbcCore(エービーシーコア)」の開発/提供を行う慶応義塾大学発のベンチャー企業だ。

リアルハプティクスとは、ヒトがロボットを操作して現実の物体に接触した際の力や動きをデータ化し、そのデータをリアルタイムで双方向に伝送することで感触(柔らかさ、重さ、手触り)、力加減といった「力触覚」を自在に表現できる技術だ。

リアルハプティクスの特長について、モーションリブ 営業・マーケティング部の福田綾子氏は「従来の制御技術では難しかった『力制御』と『位置制御』の統合制御を実現した世界初の技術だ。これにより、柔らかい感触から硬い感触まで再現が可能になった」と語った。

AbcCoreは、アクチュエーターなどの力加減、位置、速度の抽出および制御を行う力感触制御ICチップだ。力加減は0.1ミリ秒で計測/数値化でき、計測から制御(反映)までの時間は有線通信の場合は0.2ミリ秒だ。無線通信の場合、計測から制御までの時間は通信環境に依存する。なお、ローカル5G(第5世代移動通信)や低軌道衛星インターネットサービス「Starlink」などに対応しているという。

定型動作の記録/再現であればICのみで実現可能で、学習や応用動作を実行するためには、アプリケーションやプログラム側での設定が必要になる。1つのICで2つのモーターを制御可能で、複数個を組み合わせることで幅広い用途に活用できる。抽出可能な力触覚(力の強度)はモーターに依存し、「分解能が高いモーターであれば、ミジンコが泳ぐ(移動する)際の細かな動きも検知できる」(福田氏)という。

【訂正:2024年3月6日20時09分 当初の記事では「リアルハプティクスとは、ヒトがロボットを操作して現実の物体に接触した際の力や動きをあらかじめデータ化しておき、(中略)力加減といった「力触覚」を自在に表現できる技術だ」としておりましたが、リアルタイムなデータ化であるため、「あらかじめ」の表記を削除しました。また、「精度が高いモーターであれば」は、正しくは「分解能が高いモーターであれば」です。お詫びして修正致します。】

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング