ローエンド型破壊イノベーションを起こしたDeepSeek 〜ウエハー需要への影響は:湯之上隆のナノフォーカス(79)(3/6 ページ)

サーバに占めるAIサーバの割合

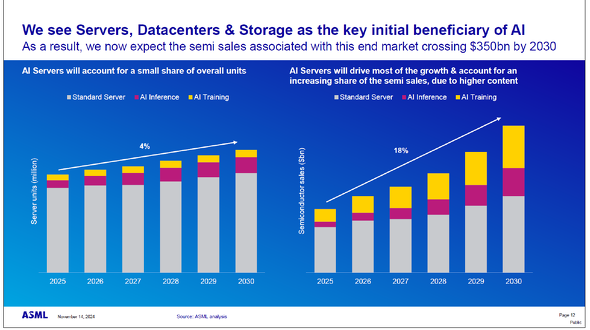

図6には、標準的なサーバ、推論(Inference)用AIサーバ、学習(Training)用AIサーバの出荷動向が示されている。

図6 AIサーバ(推論と学習)の出荷台数と出荷金額の推移[クリックで拡大] 出所:2024年11月14日 “ASML Investor Day” “End markets, wafer demand and lithography spending”/Amit Harchandani氏

図6 AIサーバ(推論と学習)の出荷台数と出荷金額の推移[クリックで拡大] 出所:2024年11月14日 “ASML Investor Day” “End markets, wafer demand and lithography spending”/Amit Harchandani氏まず、図6の左側のグラフを見ると、全体のサーバ出荷台数は年率4%で増加すると予測されている。2025年時点では、推論用と学習用のAIサーバの出荷台数はほぼ同程度だが、その後、推論用AIサーバの出荷が徐々に増加すると見込まれている。ただし、2030年時点で推論用と学習用のAIサーバを合わせても、全サーバ出荷台数の約20%にとどまると予測されている。

一方、図6の右側のグラフに示されたサーバ向け半導体の出荷金額を見てみると、状況は大きく異なる。全サーバ向け半導体の出荷金額は年率18%と大幅に成長し、特に学習用AIサーバ向け半導体の出荷金額が推論用AIサーバ向けを上回るようになる。2030年には、全サーバ向け半導体の出荷金額の約50%が推論用および学習用AIサーバ向け半導体によって占められると予測されている。

このようにして、2030年にはサーバ向け半導体の出荷金額が3500億米ドルを超え、世界の半導体市場全体の34%を占めるまでに成長する。また、学習用AIサーバの出荷台数は推論用より少ないにもかかわらず、学習用AI半導体の出荷金額は推論用を大きく上回る。これは、生成AIの高度化に伴い、より高性能な計算能力が求められるため、NVIDIAのGPUをはじめとする学習用AI半導体の価格が高騰し続けることを示唆している。

ここで、低コストでのAIモデルの開発が可能になったDeepSeekが、上述の流れにどのような影響を与えるかについては、いくつかのシナリオが考えられる。一部には、もはやNVIDIAのGPUなどの高性能なAI半導体は不要になるという主張もある。しかし、筆者はそうは考えない。

DeepSeekが行ったような「蒸留」によってAIモデルを開発する場合でも、その教師となるAIモデルが必要であり、それを訓練するためには、より高性能なAI半導体が不可欠だからである。

では、本格的なAI時代を迎える中で、ロジック、DRAM、NAND型フラッシュメモリ(以下、NAND)などの各種半導体に使用されるウエハー需要は、今後どのように変化していくのだろうか?

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか