人の“模倣”ではないAIで、未来を作る:NTT R&Dフォーラム 2016(3/3 ページ)

ロボットとデバイスをクラウド上で連携

IoT向けには、対話型ロボットとタブレット端末、ヘルスケア機器など、さまざまなデバイスをクラウド上で連携させてアプリケーションを開発できる統合開発環境/実行環境として「R-env:連舞(れんぶ)」を紹介した。

R-env:連舞の使い方はとてもシンプルで、「スイッチを押したらロボットがあいさつする。ロボットがあいさつしたら、ロボット掃除機が動く」といった具合に、簡単な状態遷移表を作成していけばよい。動作の項目も「スイッチを押す」「ロボットが話す」といったようにあらかじめ用意されているので、ユーザーは、実現したい動作をプルダウンで選択するだけでよい。

左=「R-env:連舞」の画面。このように状態遷移表を作成していく。吹き出しは、説明用であって、実際の画面にはない/中央=対話型ロボットやスイッチ、ロボット掃除機など、さまざまなデバイスを連携させるアプリを開発しやすくなる/右=ロボットとタブレット端末、血圧計などを連携させ、「血圧を計測する→結果がタブレット端末に表示される→ロボットが“次の測定にどうぞ”などとしゃべる」といった健康診断のシステムも、開発できる(クリックで拡大)

左=「R-env:連舞」の画面。このように状態遷移表を作成していく。吹き出しは、説明用であって、実際の画面にはない/中央=対話型ロボットやスイッチ、ロボット掃除機など、さまざまなデバイスを連携させるアプリを開発しやすくなる/右=ロボットとタブレット端末、血圧計などを連携させ、「血圧を計測する→結果がタブレット端末に表示される→ロボットが“次の測定にどうぞ”などとしゃべる」といった健康診断のシステムも、開発できる(クリックで拡大)眼球の動きでマインドリーディング

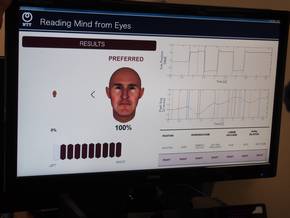

眼球の動きから心理を読み取る技術として、“好みのタイプ”を判別するデモが行われた。CG(コンピュータグラフィックス)で作成した人の顔の画像を2枚並べ、どちらをより好んでいるかを、眼球の動きや瞳孔の収縮で判断するというもの。カメラで眼球を撮影し、眼球の動きと瞳孔の収縮を見ながら、アルゴリズムを使って、どちらの画像が好みなのかを判別している。NTTによると、判別の精度は約90%だという。

NTTは、同技術の用途として、運転中に眠気をリアルタイムに推定してドライバーに注意喚起したり、スポーツで、プレー中の眼球データを取得し、選手にフィードバックしてマインドコントロールに役立てたりといったことを挙げた。NTTは、「目の動きと自律神経系は深く関与しているといわれている」と述べ、自律神経系の疾患を見つけるといったことにも使える可能性を示した。

左=デモの様子。目の前にあるカメラで、眼の動きなどを捉える/右=デモの体験者によると、この顔が好みだということで「正解」だそう。それにしても、CGで作成した顔は本当に怖かった。「せめてきれいなモデルさんの写真を用意してほしかった」(体験者) (クリックで拡大)

左=デモの様子。目の前にあるカメラで、眼の動きなどを捉える/右=デモの体験者によると、この顔が好みだということで「正解」だそう。それにしても、CGで作成した顔は本当に怖かった。「せめてきれいなモデルさんの写真を用意してほしかった」(体験者) (クリックで拡大)VRを利用してバッティングの練習を

高い臨場感や没入感を実現する技術として、VR(Virtual Reality:仮想現実)を用いた野球のトレーニングのデモを紹介した。複数台のカメラを使って異なる角度から撮影した野球場やピッチャーの映像と、ボールなどのCG映像と合成し、ヘッドマウントディスプレイ(HMD)で再現するもの。あたかも、バッターボックスに立ち、実際にピッチャーと勝負しているような感覚を得られる。カメラの映像だけでなく、モーションセンサーなど各種センサーから取得した情報も追加することができる。実際の試合のような状況を作り出せる同技術は、練習だけでなくゲームなどエンターテインメントの分野でも使えるとしている。

関連記事

自動運転の実現はまだ遠く、トヨタがCESで語る

自動運転の実現はまだ遠く、トヨタがCESで語る

トヨタ自動車は「2016 International CES」で、人工知能の研究開発のための新会社「Toyota Research Institute」について説明するとともに、自動運転の展望について語った。 ウェアラブルの世界で花開くAR技術

ウェアラブルの世界で花開くAR技術

AR(拡張現実)・VR(仮想現実)技術への関心が、ここ1年でさらに高まっている。特にスマートグラスと相性がよいAR技術は、ソニー、Apple、Googleなど大手メーカーからの注目度も高く、同分野への投資が積極的に進んでいる。 おもてなしは最先端のユニバーサルデザインで

おもてなしは最先端のユニバーサルデザインで

羽田空港で、最先端のユニバーサルデザインを用いた実証実験が始まる。年々増える外国人観光客など、空港利用客に“最高のおもてなし”を実現すべく、パナソニック独自の「光ID技術」やNTTの「音声処理技術」といった最新技術を駆使している。 「これまでのロボット掃除機は“掃除機”ではない」――ダイソン 360 Eyeの開発者に聞く

「これまでのロボット掃除機は“掃除機”ではない」――ダイソン 360 Eyeの開発者に聞く

16年に及ぶ開発期間を経てロボット掃除機「360 Eye」を発表したダイソン。カメラで全方位を見回し、自身の位置をミリ単位で把握して掃除を行う。デジタルモーターの他、ゴミと空気を遠心力で分離するサイクロン機構も一から開発し、強い吸引力を追求した。ダイソンでロボット工学主任を務めるMike Aldred氏は、「これまでのロボット掃除は、ロボットではあるが“掃除機”とは呼べない。自分たちで“本物のロボット掃除機市場”を作る」と強調した。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか