Armの独壇場にはならない? AI向けコア市場:他メーカーの猛攻が始まっている(2/2 ページ)

優れたベンチマークが必要に

最終的に、このまだ新しい市場での競争で勝利を獲得するのは、性能と電力、ダイ面積の最適な組み合わせを実現する半導体チップだろう。

Gwennap氏は、「問題なのは、われわれはチップ自体の性能を気にしてしまう傾向にあるという点だ。本当は、ニューラルネットワーク上で動作したときの性能を見るべきなのである。そのためには、例えば“1秒間で分類できる画像の数”といったような、優れたベンチマークが必要になるだろう」と指摘する。

Baiduは、早い段階からAIベンチマークをオープンソースとしてリリースしていたが、広く普及するには至っていない。トランザクション処理性能評議会(TPC:Transaction Processing Council)は2017年末に、問題の解決に向けてワークグループを設立したが、今のところまだ何の進展もないようだ。

Gwennap氏は、「ベンチマークを考えるのは簡単だが、メーカー各社の合意を得て結果を比較することが難しい。物事は常に変化するため、どのベンチマークも、関連性を維持するために進化させる必要がある」と述べる。

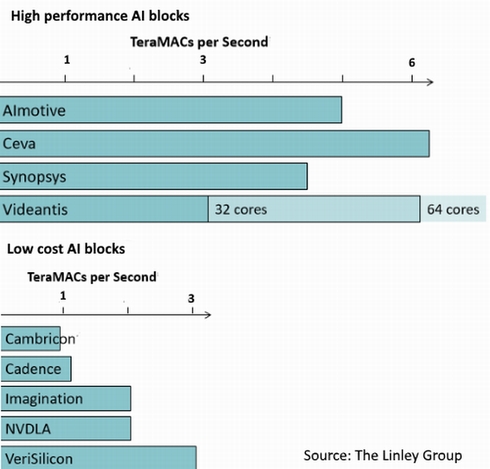

同氏によると、現在のところ、Videantisが発表したマルチコア「v-MP6000」は、一番近い競争相手であるCEVAの「NeuPro」の性能を、わずかに上回っているという。NeuProは、SIMD DSPとシストリックMACアレイを組み合わせている。

この他にも、Synopsysの「EV64」は、活性化/プーリング向けにSIMD DSPとカスタムロジックを組み合わせている。また、AImotiveの「AIware」は、Videantisと同様に、多くのカスタムハードウェアブロックを使用しているという。

低コストの製品群の中では、VeriSiliconの「VIP8000-O」が、GPUと最大8個の深層学習エンジンと組み合わせたときに、最高クラスの性能を実現しているようだ。皮肉なことに、CambriconのCPUは、小型のマトリックスエンジンを搭載し、既に発表されているチップの中でも最も性能が低いが、Huaweiのスマートフォンで重要なデザインウィンを確保している。

また、Imagination Technologiesも、MACアレイを搭載した非GPUアーキテクチャの「PowerVR 2NX」を投入している。NVIDIAは、プロセッサ「Xavier」のNVDLAコア向けIPをオープンソースで無償提供することにより、Armのサポートを獲得した。

データセンター向けAIチップで確固たる地位を持つNVIDIA

Gwennap氏は、「現在のところ、全体で約40社もの企業がAIチップを開発している状況にある。その多くはデータセンターをターゲットに定めているが、そこではNVIDIAのGPU『Volta』が、Amazonなどの巨大ハイテク企業のトレーニングエンジンとして採用されており、確固たる地位を確立している」と述べる。

同氏は、「今のところVoltaの競合製品としては、Googleのアクセラレータチップ『Tensor Processing Unit(TPU)』と、MicrosoftのFPGAベースの機械学習用システム『Brainwave』とみている。これら以外の選択肢として挙げられるメーカーは、それほど多くない」と語った

「Wave Computingは2018年中に、新しいAIデータセンター向けアーキテクチャを実用化する予定だとしており、一歩抜きんでることになるだろう」(同氏)。Wave Computingは、完全なシステムを提供することを目指していることから、同社のターゲットは、独自に最適化された大規模なデータセンターではなく、ティア2およびティア3サプライヤーだと考えてよいだろう。

Intelは最近、「Nervana」の製造が2019年以降になる見通しであることを明らかにした。新興企業であるGraphcoreは、2018年後半に半導体チップを発表する予定だとしている。また、もう1つの新興企業Cerebrusは、何も動きがない状態が続いているが、ビットコインASICを手掛けるBitMainは2017年末に、データセンター向けAIチップの開発予定を明らかにしている。

【翻訳:田中留美、編集:EE Times Japan】

関連記事

AI搭載IoT機器の普及には、安価なチップが不可欠

AI搭載IoT機器の普及には、安価なチップが不可欠

スマートホーム向けの照明システムの開発を手掛ける米Noon Homeは、IoTに機械学習を取り込むために、より安価なSoC(System on Chip)やDRAMの重要性を主張している。 ArmのAI戦略、見え始めたシナリオ

ArmのAI戦略、見え始めたシナリオ

機械学習についてなかなか動きを見せなかったArmだが、モバイルやエッジデバイスで機械学習を利用する機運が高まっているという背景を受け、少しずつ戦略のシナリオを見せ始めている。 ARMの新型コア「Cortex-A75/A55」、AIを促進

ARMの新型コア「Cortex-A75/A55」、AIを促進

「COMPUTEX TAIPEI 2017」開催前日の記者説明会で、ARMが新型CPUコア「Cortex-A75」と「Cortex-A55」を発表した。最大8種類の異なるCPUコアを1クラスタ上に構成できるアーキテクチャ「DynamIQ」をベースにした、最初のCPUコアとなる。新Cortex-Aシリーズの最大のターゲット市場は、AI(人工知能)だ。 関心高まるRISC-V、Armやx86の代替となり得るか

関心高まるRISC-V、Armやx86の代替となり得るか

2017年11月28〜30日にかけて、米国シリコンバレーで「7th RISC-V Workshop」が開催された。オープンな命令セットアーキテクチャ「RISC-V」は、Arm系やx86系の命令セットの代替となり得る技術として確実に台頭してきている。 ARM、AI開発専門のグループを設立

ARM、AI開発専門のグループを設立

ARMは、機械学習(マシンラーニング)を専門に開発するグループを新たに設立することを発表した。 Intel、IoTを巡ってARMと対決

Intel、IoTを巡ってARMと対決

Intelがこのほど、自動車、産業機器市場向けのリアルタイム性能を備えた新SoCを発表したことで、ARMとのIoT(モノのインターネット)の市場を巡る戦いが激化しつつある。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

AIチップの積和演算性能比較 出典:The Linley Group

AIチップの積和演算性能比較 出典:The Linley Group