Cerebras、人間の脳に匹敵するAIシステムを発表:120兆個のパラメータの学習を実現

Cerebrasは、2021年8月22〜24日にオンラインで開催された「Hot Chips 33」で、自社の次世代AI(人工知能)アクセラレーター「CS-2」に向けた新たなメモリ拡張技術やソフトウェア実行アーキテクチャを発表した。それにより、単一のウエハースケールチップで120兆個のパラメータモデルをトレーニングできるようになるという。

Cerebrasは、2021年8月22〜24日にオンラインで開催された「Hot Chips 33」で、自社の次世代AI(人工知能)アクセラレーター「CS-2」に向けた新たなメモリ拡張技術やソフトウェア実行アーキテクチャを発表した。それにより、単一のウエハースケールチップで120兆個のパラメータモデルをトレーニングできるようになるという。なお、人間の脳には約100兆個のシナプスがあるといわれる。

CerebrasのCEO(最高経営責任者)であるAndrew Feldman氏は米国EE Timesに対し、「当社が携わる領域は過去2年間で桁外れの進化を経験した。モデルのパラメータ数は1000倍以上に拡張し、作業にかかる時間も1000倍以上になった」と述べた。

Feldman氏は、大規模な自然言語処理モデルが、「BERT」ベースの1億1000万パラメータから、「GPT-3」のような1750億以上のパラメータを持つモデルへと進化したことに言及した。1024台のGPUでトレーニングするGPT-3は、トレーニングに4カ月の時間と数メガワットの電力を要するという。

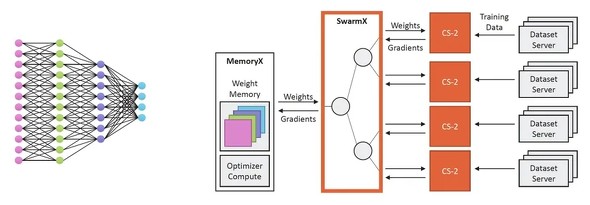

こうした自然処理言語モデルの急成長に追従すべく、Cerebrasは演算エンジンであるCS-2向けのメモリ拡張技術「MemoryX」を開発した。DRAMとフラッシュストレージを組み合わせたMemoryXは、最大2.4ペタバイトの容量を実現し、全てがオンチップであるかのように動作する。最大120兆個のパラメータを持つモデルをサポートすることができる。MemoryXにより、小型冷蔵庫ほどのサイズのCS-2システム1台で、既存の最大のモデルを“週末の間に”トレーニングすることが可能になるという。

Feldman氏は「このメモリアクセス技術を用いれば、極めて大規模なネットワークで活用できるだろう」と述べた。MemoryXには、重み付けのアップデートを正確に計画して実施するソフトウェアが含まれている。

新しいソフトウェア実行アーキテクチャ

Cerebrasは新しいソフトウェア実行アーキテクチャ「Cerebras Weight Streaming」も発表した。

既存のより小型のモデルでは、パラメータと重みはウエハー(チップ)上に保持され、アクティベーションデータはストリーミングされる。このパイプライン型の実行モードは、モデル全体をCS-2上にロードでき、非常に低いレイテンシで処理できることを意味する。

一方、極めて大規模なモデル向けの新たな実行アーキテクチャであるWeight Streamingでは、モデルの重みは中央ストレージに保持されてウエハー上にストリーミングされる。トレーニングのデルタパスでは、勾配はウエハーから中央ストレージにストリーミングされて重みを更新するために利用される。

SwarmX技術

Cerebrasは、AIに最適化した通信ファブリック「SwarmX」も発表した。最大192台のCS-2にまたがって最大1億6300万個のAIに最適化したコアを接続し、協調して1つのニューラルネットワークをトレーニングできるようになる。Feldman氏によれば、CS-2を追加していけば、性能をほぼリニアに向上できるという。

モデルレイヤー全体を1台のCS-2にロードすることでシンプルになるため、1台のCS-2から複数台のCS-2へのアップグレードもソフトウェアの変更なしに行うことができる。

【翻訳:青山麻由子、編集:EE Times Japan】

関連記事

TED、巨大AIチップのCerebrasと代理店契約締結

TED、巨大AIチップのCerebrasと代理店契約締結

東京エレクトロン デバイス(以下、TED)は2019年12月19日、Cerebras Systems(セレブラスシステムズ/以下、Cerebras)と販売代理店契約を締結し、Cerebrasの超高速ディープラーニングシステムの受注を開始したと発表した。TEDでは今後3年間で、同システムの販売を中心にAI(人工知能)/ディープラーニング関連事業で売上高100億円程度を見込む。 1000コアを搭載、RISC-VベースのAIアクセラレーター

1000コアを搭載、RISC-VベースのAIアクセラレーター

新興企業Esperantoは、これまで開発の詳細を明らかにしてこなかったが、2021年8月22〜24日にオンラインで開催された「Hot Chips 33」において、業界最高性能を実現する商用RISC-Vチップとして、ハイパースケールデータセンター向けの1000コア搭載AI(人工知能)アクセラレーター「ET-SoC-1」を発表した。 IBMの「Telum」プロセッサ、不正をリアルタイムで検知

IBMの「Telum」プロセッサ、不正をリアルタイムで検知

IBMは、トランザクション実行中にAI処理を高速に実行するためのオンチップ・アクセラレーションを搭載したプロセッサ「IBM Telumプロセッサ」について、その詳細を「HotChips」カファレンスで発表した。 車載で存在感を増すImagination、AIとのシナジーも強化

車載で存在感を増すImagination、AIとのシナジーも強化

25年以上にわたりGPUコアを提供している英Imagination Technologies(以下、Imagination)は、順調に売上高を伸ばし、新しいGPUコアのシリーズを立ち上げ、その製品ラインアップを増やしている。オートモーティブはImaginationにとって中核市場の一つだ。 推論を加速する光コンピューティングプロセッサ

推論を加速する光コンピューティングプロセッサ

米国のLightmatterは、2020年8月16日〜18日にバーチャルで開催された「Hot Chips 32」でテストチップを発表した。同社は米マサチューセッツ工科大学(MIT)のスピンアウト企業で、AI(人工知能)アクセラレーション向けオプティカルコンピューティングプロセッサの開発を手掛ける。 複数AIアクセラレーター搭載の評価チップを試作

複数AIアクセラレーター搭載の評価チップを試作

新エネルギー・産業技術総合開発機構(NEDO)と産業技術総合研究所(産総研)および、東京大学は共同で、仕様が異なる6種類のAIアクセラレーターを搭載した評価チップ「AI-One」を設計、試作を始めた。これを活用すると、短い期間で安価にAIチップの設計と評価が可能になる。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

CerebrasのCEO(最高経営責任者)、Andrew Feldman氏 出典:Cerebras

CerebrasのCEO(最高経営責任者)、Andrew Feldman氏 出典:Cerebras