「エッジでLLM」を実現するNXPの戦略 鍵はKinara買収とRAG:医療機器や自動車でも(2/2 ページ)

RAGや音声UIモデルなどエッジ特化のツールを用意

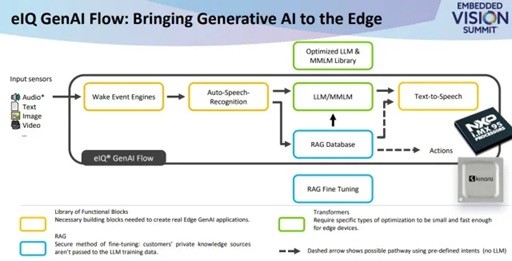

NXPは、Kinaraの買収に加えて、LLMと生成AIをエッジで実行するための新しいツールフローについても発表している。「GenAI Flow」は音声認識や音声合成(text-to-speech)モデルを含む機能的なライブラリを備える。Ors氏は「組み込み機器はシステムにキーボードやディスプレイを備えていない場合があるので、音声UIに関連するモデルは非常に重要だ」と指摘する。こうしたモデルは、i.MX95の場合はアプリケーションプロセッサのNPUで、より旧型の場合はCPUでなど、ホスト上でも実行可能だという。

Ors氏は「GenAI Flowはワークロードの一部をコア間で分割できるが、個々のモデルを複数のコアに分割するのは非常に困難だ」と述べる。

また同氏は「モデルは動的なもので、そのバランスのとり方に注意する必要がある。グラフを分割し始めると必ず、それまでは存在していなかったボトルネックが発生する。何度もあちこちデータを受け渡していると、計算よりも受け渡しに多くの時間を費やすようになる可能性がある。このため、何か利用できるものを探してそのコアにデータを送信するよりも、動作は遅くても全てを1カ所で実行する方が良いかもしれない」と述べる。

GenAI Flowには、RAG(Retrieval-Augmented Generation:検索拡張生成)向けのツールもある。RAG技術は、事実に基づいていることが重要視される自動車や産業、ヘルスケアなどのエッジユースケースにおいて、LLMにコンテキストを与える。

「畳み込みニューラルネットワーク(CNN)の場合、多くの製品化がカスタムモデルで行われる。LLMではカスタムモデルのコストがかなり大きく、より多くのデータや計算、特殊な専門知識が必要とされ、それを確保することは非常に難しい。専門知識や計算のコストも高く、特にデータ収集のコストは非常に高い」(Ors氏)

こうした理由から、ほとんどのエッジ顧客がLlamaのようなオープンソースLLMをRAGなどの技術と組み合わせて利用する方を好む。RAGによって、LLMは事実に基づいたコンテンツのデータベースにアクセスできる。エッジアプリケーションの場合、RAGデータベースのサイズは数百キロバイトで、アプリケーションプロセッサ上で動作する。GenAI Flowは、NXPハードウェア向けにあらかじめ最適化されたオープンソースモデルのライブラリを備えている。

Ors氏は「これらのモデルは現在もありとあらゆるトレーニングの最中だが、RAGはそのトレーニングにコンテキストを提供できる」と述べる。

「LLMが医療機器上で実行されている場合は、その機器の使用方法に関する全てのマニュアルを組み込める。そうすればLLMに質問したときに、インターネットで見た心電図の画像を参考にするのではなく、その医療機器が実際にやろうとしていることに基づいた応答を得られる。RAGは、事実に基づいて応答することが非常に重要な用途において、オープンソースLLMにコンテキストを与える」(Ors氏)

重要なのは、RAGはモデルを修正しないということだ。Ors氏によれば、今後のAI規制を懸念する顧客の多くがそれを望んでいるという。認証されたモデルにRAGを介してコンテキストを与える際に、追加の認証を受ける手間を省略できる可能性があるからだ。

全体としてGen AIは、LLMをエッジに導入して顧客の摩擦を取り除くことを目的にしている。エッジにおける完全なエージェントAIの実現はまだ先のことだが、Ors氏によるとこの技術はエッジユースケースにおいて大きな可能性を秘めているという。

「生産現場で防犯カメラが事故を捉えたとき、エージェントAIが現場の状況を読み解き、管理者や救急隊を呼び、報告書の作成を開始し、関連する機械を停止させる。これらは全て実現可能なことだ」(Ors氏)

【翻訳:田中留美、編集:EE Times Japan】

関連記事

AMDがAI新興Untether AIのエンジニアチーム「だけ」買収

AMDがAI新興Untether AIのエンジニアチーム「だけ」買収

AMDは2025年6月、カナダのトロントに拠点を置くAIチップのスタートアップ企業であるUntether AIのエンジニアリングチームを買収した。技術は買収していないので、Untether AIのプロセッサ「SpeedAI」およびソフトウェア開発キット(SDK)「ImAIgine」は今後供給もサポートもされないという。 商用化から40年を迎えたFPGA、次の主戦場はエッジAI

商用化から40年を迎えたFPGA、次の主戦場はエッジAI

FPGAが初めて商用化されてから40年がたった。1985年に初の商用化FPGA「XC2064」を投入したAMDは現在、30億個を超えるFGPA/アダプティブSoCを出荷している。同社のAdaptive and Embedded Computing Groupでシニアバイスプレジデント兼ゼネラルマネジャーを務めるSalil Raje氏に、FPGAの課題や、これからの注力市場について聞いた。 産業機器×LLMで「ベテラン技術者」を再現、操作をサポート

産業機器×LLMで「ベテラン技術者」を再現、操作をサポート

NXPは「第9回 AI・人工知能 EXPO 春」内「小さく始めるAIパビリオン」にて、組み込み機器上で大規模言語モデル(LLM)を動作させるデモを紹介し、産業機器のユーザーガイドとしての利用例を提案した。 独自NPUで差異化 広範なマイコン群でエッジAIを支援するNXP

独自NPUで差異化 広範なマイコン群でエッジAIを支援するNXP

AI(人工知能)関連技術の進展が加速する中、エッジデバイス上でAI推論を行うエッジAIの導入が進んでいる。中でも、より低消費電力/低コストのマイコンを用いるケースへの注目が高まっている。マイコン/プロセッサを多く手掛けるNXP SemiconductorsのエッジAI向け戦略とポートフォリオについて、NXPジャパンに聞いた。 NXP、AI/機械学習開発ソフトウェアに新機能追加

NXP、AI/機械学習開発ソフトウェアに新機能追加

NXP Semiconductorsは、AI/機械学習開発ソフトウェア「eIQ」に、新たな2つのツールを追加した。新機能を活用することで、ローエンドマイコンから高性能アプリケーションプロセッサまで、幅広いエッジ製品向けプロセッサでのAI利用が容易となる。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- TIがSilicon Labsを75億ドルで買収する理由

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- TSMCが熊本第2工場で3nm導入へ CEOが表明

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

- 「何でもできるが誰にも使えない」――自作MASが突きつけた現実

- ソニー半導体、3Qは過去最高 通期予想もさらに上方修正