Armサーバ向けのレファレンスデザイン、NVIDIAが発表:スパコンなどの用途にも

NVIDIAは2019年11月18日(米国時間)、GPUアクセラレーションArmベースサーバを構築するためのレファレンスデザインプラットフォームを発表した。「Supercomputing 2019」で発表されたもので、NVIDIAはこの他に2件の発表も行っている。

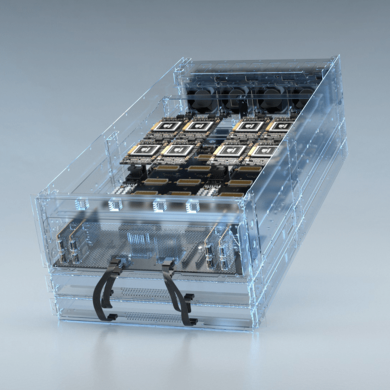

NVIDIAは2019年11月18日(米国時間)、GPUアクセラレーションArmベースサーバを構築するためのレファレンスデザインプラットフォームを発表した。米国コロラド州デンバーで開催中の「Supercomputing 2019」(2019年11月17〜21日)において、同社が明らかにしたところによると、Ampere、Cray、富士通、HPE、Marvell Technology Groupは、スーパーコンピュータ(スパコン)を含むさまざまな用途に向けて、Armベースのサーバを構築する計画だという。

NVIDIAは過去8年にわたり、スパコン向けにArmプロセッサを試してきたが、全面的にサポートしてきたのはx86やPOWERから成るエコシステムのみだった。2018年夏、同社はソフトウェアプラットフォーム「CUDA-X」で完全にArmをサポートする計画について明言していた。今日の発表によって、その約束を果たした格好となる。まずはArm互換のSDK(ソフトウェア開発キット)のプレビュー版を公開している。

Armはスパコンにますます用いられているようになっている。NVIDIAは、米国のOak Ridge and Sandia National Laboratories、英国のUniversity of Bristol、日本の理研(理化学研究所)が、GPUアクセラレーションArmベースのコンピュータシステムのテストを開始したと伝えた。スパコン分野におけるArmの成功は、ハイパースケールクラウド事業者や企業の注目を集めている。

Armアーキテクチャはハイスループット、アプリケーションの低遅延、電源管理のために開発された。Armのライセンシー(ライセンス利用者)によると、これらの要素は、データセンターにある人工知能(AI)や機械学習(ML)の作業負荷と特に密接な関係があるという。

NVIDIAにとっての課題は、GPUと他社の個々のArm実装が確実に連携するようにすることだが、報道機関とのプライベートなブリーフィングの中で、NVIDIAは、Ampere、富士通、Marvellのシステムと円滑に、かつ確実に統合できるようにするための取り組みを進めていることを明らかにした。

Azure上で動作するGPUアクセラレーションスパコン

NVIDIAは今回のイベントで、別の発表も2件、行っている。一つはソフトウェアスイート「Magnum IO」だ。GPUがメモリから直接データにアクセスするためのパスを作り、CPUをバイパスすることで性能を大幅に高めるという。これにより、データセンターにある「ストレージならびに入出力のボトルネックを排除できるよう最適化されている」(同社)という。

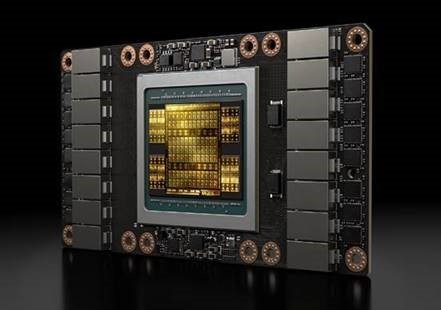

もう一つの発表は、Microsoftの「Azure」で利用できる、クラウド上で動作する新たなタイプのGPUアクセラレーションスパコンだ。Azureの新しいNDv2 インスタンスで、単一のMellanox InfiniBandバックエンドネットワークで相互接続された最大800の「V100 Tensor」コアGPUを提供する。

これにより、顧客は、AIスパコンをデスクからオンデマンドでレンタルできるようになるという。最もベーシックなNC6インスタンスは、1時間当たり90米セント(長期のサブスクリプションなら1時間当たり30米セント)で利用可能だ。

NVIDIAとMicrosoftは、64台のNDv2インスタンスを実行し、一般的な対話型AIモデルである「BERT」のトレーニングを約3時間行った。

NVIDIAによれば、全てのNDv2インスタンスは、NVIDIA NGCコンテナレジストリおよびAzure Marketplaceから、GPUに最適化されたHPC(High Performance Computing)、機械学習ソフトウェア、TensorFlowやPyTorch、MXNetといった深層学習フレームワークを活用できるという。

【翻訳:青山麻由子、編集:EE Times Japan】

関連記事

AzureでAIチップにアクセス可能、機械学習を高速化

AzureでAIチップにアクセス可能、機械学習を高速化

Microsoftは、同社のクラウドプラットフォーム「Azure」の顧客に対し、英国の新興企業GraphcoreのAIアクセラレーターチップ「Colossus Intelligence Processing Unit(IPU)」の利用提供を開始した。 「富岳」プロトタイプ、スパコン消費電力性能で世界1位

「富岳」プロトタイプ、スパコン消費電力性能で世界1位

富士通は2019年11月18日、同社と理化学研究所が共同で開発を進めるスーパーコンピュータ「富岳」のプロトタイプが、スパコンの消費電力性能を示すランキング「Green500」で世界1位を獲得した、と発表した。 NVIDIA、99ドルのAIコンピュータを発表

NVIDIA、99ドルのAIコンピュータを発表

NVIDIAは、高い演算性能を持ちながら消費電力が小さいCUDA-X AI(人工知能)コンピュータ「Jetson Nano」を発表した。開発者や個人のクリエーターなどに向けた「開発者キット」の価格はわずか99米ドルである。 NVIDIAの「Jetson Xavier NX」、性能は10Wで14TOPS

NVIDIAの「Jetson Xavier NX」、性能は10Wで14TOPS

NVIDIAは2019年11月6日(米国時間)、新しいAI(人工知能)ボード「Jetson Xavier NX」を発表した。同社のシングルボードコンピュータ「Jetson Nano」のフォームファクタ(70x45mm)で、「Jetson AGX Xavier」と同等の計算能力を備える。 「半導体が産業の主役に」SEMICON Japan 2019の狙い

「半導体が産業の主役に」SEMICON Japan 2019の狙い

2019年12月11〜13日、マイクロエレクトロニクス国際展示会「SEMICON Japan 2019」が、東京ビッグサイトで開催される。今回のキーメッセージは、「次代のコアになる。」だ。主催者であるSEMIジャパンで代表を務める浜島雅彦氏に、SEMICON Japan 2019の狙いや見どころなどを聞いた。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

GPUアクセラレーションスパコン 画像:NVIDIA

GPUアクセラレーションスパコン 画像:NVIDIA