「Intelは全方位にAIを展開」、汎用GPUにも進出:エッジからクラウドまで

Intelの日本法人であるインテルは2019年11月27日、AI(人工知能)におけるIntelの取り組みを説明する発表会を都内で開催した。Intelは同年11月12日(米国時間)に米国カリフォルニア州サンフランシスコで「AI Summit 2019」を開催し、AI向けの新製品を発表したが、その内容の一部を日本の報道機関向けに説明するというもの。

Intelの日本法人であるインテルは2019年11月27日、AI(人工知能)におけるIntelの取り組みを説明する発表会を都内で開催した。Intelは同年11月12日(米国時間)に米国カリフォルニア州サンフランシスコで「AI Summit 2019」を開催し、AI向けの新製品を発表したが、その内容の一部を日本の報道機関向けに説明するというもの。

インテル執行役員常務 技術本部 本部長の土岐英秋氏によれば、2019年におけるIntelのAI関連売上高は35億米ドルに上るという。同氏は、「AIはあらゆる領域に浸透し始めているが、Intelも(エッジからクラウドまで)全方位にAIを展開していく。セキュリティも含めて展開していく」と強調した。

エッジ向けの学習および推論チップとしては、次世代の「Movidius Myriad VPU(Vision Processing Unit)」(開発コードネーム:Keem Bay)を発表。メモリはオンチップ搭載で、より高速なメモリ帯域を確保しているという。前世代の「Myriad X」に比べて約10倍の性能向上を実現していると土岐氏は説明する。

Keem Bayは、NVIDIAのAIコンピューティングプラットフォーム「Jetson TX2」に比べて電力当たりの推論性能が約6.2倍で、NVIDIAの「Jetson Xavier」に比べると、同等の推論性能であれば電力は5分の1になるという。単位面積(mm2)当たりの推論性能は、Jetson TX2と比較して8.7倍と主張する。

Keem Bayは2020年前半に市場に投入する予定で、チップレベル、M.2、複数のKeem Bayを搭載したカードと、複数の形で提供していく予定だ。

併せてIntelは、AI開発者向けに新しいツール「DevCloud for the Edge」も発表した。クラウド上に開発環境を用意して、開発したソースコードを、どの割合でどのアーキテクチャ(CPU、GPU、FPGA、VPU)に振り分けると、どのくらいの推論性能が出るのかをテストできるようにするというもの。「これによって、実機で検証する前に、推論のワークロードのバランスをクラウド上で確認できる」(土岐氏)

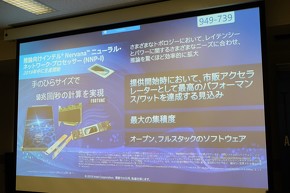

クラウド向けの機械学習向けアクセラレーターとしては、学習用の「Nervana NNP(ニューラルネットワークプロセッサ)-T1000」、推論用の「Nervana NNP-I1000」を発表。米国のイベントではデモも行ったという。両製品は一部の限定顧客に向けて提供を開始した。

NNP-I1000は1秒当たり50兆回の計算を実現できると土岐氏は強調する。NNP-I1000が32個搭載されている1Uラックと、NVIDIAの「T4」GPUが20個搭載されている4Uラックを比べた場合、ラック当たりのコンピューティング密度は最大3.7倍高くなるという。土岐氏は「エッジ側だけでなく、データセンター側でも、限られたスペースでどのくらいのコンピューティング密度を実現できるかというのは非常に重要になる」と述べる。

汎用GPU市場に参入

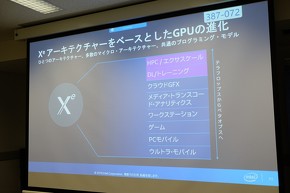

併せて土岐氏は、Intelが2019年11月17日(米国時間)に発表したHPC(High Performance Computing)や深層学習向けと最適化された汎用GPUについても触れた。Intelの「Xe」アーキテクチャをベースにしたディスクリートグラフィックスで、開発コードネームは「Ponte Vecchio」。Intelが2018年12月に発表した3D(3次元)積層技術「Foveros」や、CXL(Compute Express Link)ベースのインターコネクト「Xeリンク」が適用され、さらにIntelの次世代製造プロセスである7nmで製造される予定だ。ただし同社は、Ponte Vecchioの市場投入時期については明らかにしていない。

関連記事

Intelが3つの次世代パッケージング技術を明らかに

Intelが3つの次世代パッケージング技術を明らかに

Intelは、米国カリフォルニア州サンフランシスコで2019年7月9〜11日の日程で開催されている「SEMICON West 2019」に合わせて行われたイベントにおいて、3種類のパッケージング技術に関する同社のロードマップを初めて明らかにした。 “お蔵入りチップ”が掘り出し物に? Intel FPGAが示す過去の半導体の価値

“お蔵入りチップ”が掘り出し物に? Intel FPGAが示す過去の半導体の価値

Intel FPGAとして発表された「Cyclone 10 LP」。これには、約10年前のプロセスとシリコンが使われている。これは、何を意味しているのだろうか。 19年Q1の半導体売上高、Intelが首位に返り咲き

19年Q1の半導体売上高、Intelが首位に返り咲き

市場調査会社のIC Insightsによると、2019年第1四半期における半導体売上高ランキングにおいて、メモリ市場の低迷からSamsung Electronics(以下、Samsung)が2位に落ち、Intelが首位に返り咲いた。 戦艦Intelの方向転換なるか ―― 新CEOの使命

戦艦Intelの方向転換なるか ―― 新CEOの使命

Bob Swan氏は、米国最大の半導体メーカーであるIntelで暫定CEOを7カ月間にわたり務めた後、正式にCEOに就任することが決まった。同社は現在、50年間の歴史の中で、最も重大な岐路に立たされている。依然として、半導体市場における優位性を確保しているが、その優位性をあとどれくらいの間にわたって維持できるのかは不明だ。アナリストたちは、「Intelは、差し迫った状況に対して重大な決断を下すことにより、同社が今後、どれくらい耐えられるのかが決まるだろう」とみているようだ。 1280基のGPUを搭載した「RTX」サーバなどをNVIDIAが発表

1280基のGPUを搭載した「RTX」サーバなどをNVIDIAが発表

NVIDIAが米国カリフォルニア州サンノゼで開催した年次イベント「GTC」の基調講演では、NVIDIAが2018年秋に発表した最新プロセッサ向けの新たなシステムやソフトウェアが取り上げられた。一方で、期待されていた7nm GPUについての発表は行われなかった。 NVIDIA、99ドルのAIコンピュータを発表

NVIDIA、99ドルのAIコンピュータを発表

NVIDIAは、高い演算性能を持ちながら消費電力が小さいCUDA-X AI(人工知能)コンピュータ「Jetson Nano」を発表した。開発者や個人のクリエーターなどに向けた「開発者キット」の価格はわずか99米ドルである。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

インテルの土岐英秋氏

インテルの土岐英秋氏