ChatGPTは怖くない 〜使い倒してラクをせよ:踊るバズワード 〜Behind the Buzzword(18)(5/11 ページ)

ChatGPTとは何なのか

さて、ChatGPTとは何か、と問われれば、「使えば分かる」と答えれば十分ですが、ここからは、ChatGPTの内部の機能やら学習の方式などについて、私と同様にChatGPTのメカニズムに興味のあるAI研究者、または、ソフトウェア技術者をターゲットとして解説していきます。

まずは、ChatGPTの言葉の意味ですが、これは、Chat Generative Pre-trained Transformerの略です。これを日本語に翻訳すると「事前に訓練された変換機能を使い倒すチャット生成器」という感じになります ―― で、多分、この理解で合っていると思います(後述)。

従来のAIは、「翻訳する」「変換する」「学習する」という機能を使って、「学習した結果、あるいはその学習に沿った結果を吐き出す」という機能がメインでした。これに対して、最近よく耳にするようになった「Generative AI(生成型AI)」というのは、異なるAIの出力結果を混ぜ合わせて、あるいは異なるAI技術の機能を組み合わせて、「未知の新しいものを作り出すAI」という意味で使われています。

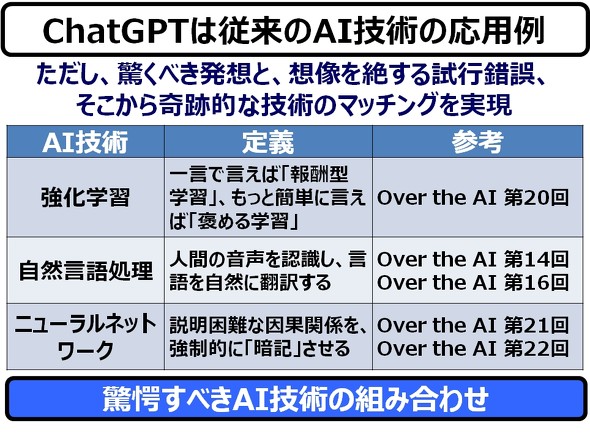

で、このChatGPTも、Generative AI(生成型AI)の一つです。ChatGPTを構成するAI技術は以下の3つになります。

このコラムでは、上記3つの技術についての説明はバッサリ省略させていただきます。上記の参考記事の方をご一読いただけますよう、よろしくお願いいたします。私のコラムは、私が私の疑問を解消することが目的でして、徹頭徹尾「江端ファースト」です。

「Over the AI」過去記事

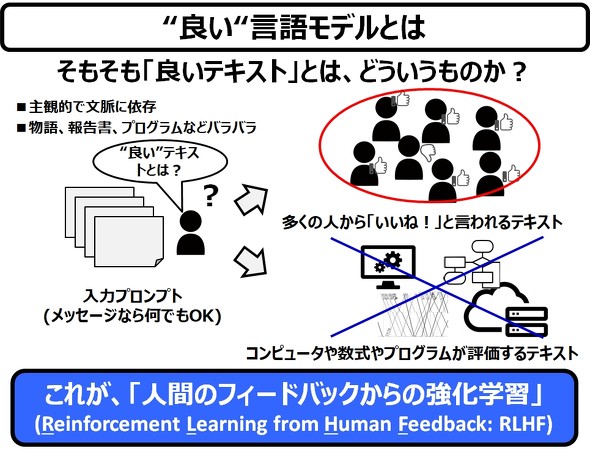

さて、先程申し上げた通り、私の疑問は「なぜ、ChatGPTは、私(たち)に違和感を与えることなく、人間が語る/書くような形式の出力ができるのか」、つまり、「なぜ、良いテキストを生成できるのか」です。この疑問に、技術面からアプローチしてみたいと思います。

そもそも「良いテキスト」とは、どういうものか ―― それは、かなりハッキリしています。「多くの人から『いいね!』と言われるテキスト」です。逆に言えば、品のないツイッターのメッセージ、人を馬鹿にする掲示板の表示などは「悪いメッセージ」と言えます。

そして、このような「良いテキスト」を、ロジカルに説明することは難しく、コンピュータや数式やプログラムには、「良いテキスト」を作り出すことはできない、ということです。ChatGPTの基本形である、GPT-3は、この割り切りからスタートしています(GPT-3については後述します)。

大ざっぱに言えば、これが、人間のフィードバックからの強化学習、Reinforcement Learning from Human Feedback: RLHFです(厳密にはちょっと違いますが、これも後述します)。

さて、このRLHFによって作られるChatGPTのコアエンジン(“本体”という理解でいいです)は、ざっくり3つのプロセスの学習(訓練)によってされます。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- TIがSilicon Labsを75億ドルで買収する理由

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- TSMCが熊本第2工場で3nm導入へ CEOが表明

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

- 「何でもできるが誰にも使えない」――自作MASが突きつけた現実

- ソニー半導体、3Qは過去最高 通期予想もさらに上方修正