EE Times Japan >

LSI >

自動運転やロボティクスにマルチモーダルLLM適用を目指す:米Ambarella(3/3 ページ)

» 2024年10月10日 15時30分 公開

[Sally Ward-Foxton,EE Times]

LLaVA-34Bを50W未満の消費電力で実行するチップ

Ambarellaは現在、N1シリコン上で6つのLLM(パラメータサイズは10億〜340億)を稼働させていて、さらにCNN(畳み込みニューラルネットワーク)ベースのビジョンモデルも14個ほど稼働しているという。この選択と微調整でほとんどのユースケースを十分にカバーできるが、他のモデルを移植することも可能だという。Ambarellaチーム最近、Google のオープンLLM「Gemma」を移植したが、それに要した時間は1週間足らずだったという。

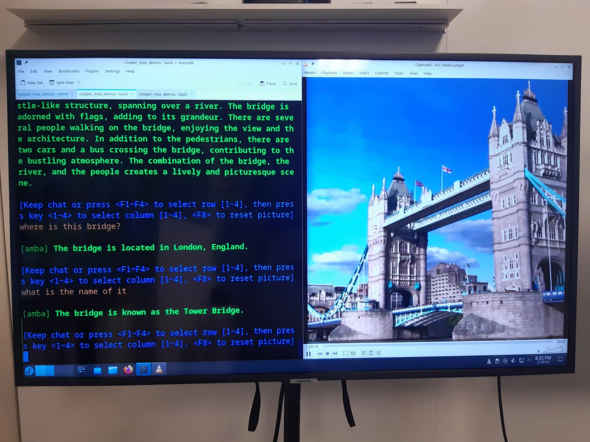

Ambarellaは米国EE Timesに向けて、オンチップAIアクセラレーションを搭載したN1ビジョンSoCのデモを、さまざまなシナリオで行った。N1は、カメラからの画像(スナップショット)の内容を記述するLLaVA-34Bを50W未満の消費電力で実行できる。あるいは、16x 1080pのビデオチャンネルでLLaVA-13Bの実行も可能だ。なおN1は、画像と自然言語を理解するマルチモーダル基盤モデルであるCLIPも実行できる。

【翻訳:滝本麻貴、編集:EE Times Japan】

関連記事

32の同時ユーザーで15トークン/秒 TenstorrentがLLMのデモを披露

32の同時ユーザーで15トークン/秒 TenstorrentがLLMのデモを披露

Tenstorrentは、同社の「LoudBox」ワークステーションのデモを披露した。Llama3.1-70B(BF8精度)を、32の同時ユーザー数で15トークン/秒/ユーザー(token/s/user)の速度で実行した。 SK hynixが12層HBM3E製品を「業界初」の量産開始

SK hynixが12層HBM3E製品を「業界初」の量産開始

SK hynixが、「業界で初めて」(同社)12層のHBM3E製品の量産を開始した。DRAMチップを40%薄くしたことで、従来の8層製品と同じ厚さで容量は36Gバイトを実現している。2024年末までに顧客に供給予定だという。 GPUの台頭と進化がサーバの消費電力を急増させる

GPUの台頭と進化がサーバの消費電力を急増させる

AI(人工知能)対応でCPUとGPUの消費電力は増大している。そのため、既存のデータセンターの冷却に大きな負担がかかっている。 AIの消費電力、学習よりも推論がはるかに大きな課題

AIの消費電力、学習よりも推論がはるかに大きな課題

Ampere Computingは、昨今急速に普及している生成AIでは、学習よりも推論の消費電力が大きな課題になると指摘した。「推論のスケールアウトの問題は、確実に破壊的な影響をもたらすだろう」と同氏は懸念を示している。 組み込み機器でも生成AIが使える 日本発のアクセラレーター

組み込み機器でも生成AIが使える 日本発のアクセラレーター

エッジAI(人工知能)向けのアクセラレーターを手掛ける日本のスタートアップEdgeCortixが、新しいプラットフォーム「SAKURA-II」を発表した。CNN(畳み込みニューラルネットワーク)モデルだけでなく、トランスフォーマーモデルを容易に実装できることが特徴だ。 「業務でちゃんと使える」特化型生成AIを自動で作る 富士通が開発

「業務でちゃんと使える」特化型生成AIを自動で作る 富士通が開発

富士通は2024年6月4日、AI分野における研究戦略発表会を開催し、企業ニーズに適した生成AIモデルを生成し、規則や法令の準拠も確認できる「エンタープライズ生成AIフレームワーク」を発表した。クエリに合わせて最適な特化型生成AIの自動生成も行う。

Copyright © ITmedia, Inc. All Rights Reserved.

Special ContentsPR

特別協賛PR

スポンサーからのお知らせPR

Special ContentsPR

Pickup ContentsPR

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

Special SitePR

あなたにおすすめの記事PR