EE Times Japan >

先端技術 >

目の動きから心の動きを読み取る、NTTの研究:瞳孔反応や眼球運動を測定(3/3 ページ)

» 2023年06月15日 16時30分 公開

[浅井涼,EE Times Japan]

興味のある話題に聞き耳を立てる

複数の話者や話題が混ざった音声から特定の音声を切り分ける音源分離は50年以上にわたって研究されてきた。これまでは音の聞こえる方向や声の周波数など、音声信号自体の物理的な特徴が用いられてきたが、CS研はそうした音声信号自体ではなく、そこに内在する意味、概念を手がかりにする研究を発表した。混合音声を概念でフィルタリングし、指定した概念に関連する音声を分離抽出する技術「ConceptBeam」だ。どのような概念をフィルターとして用いるかは、画像や音声で指定できる。

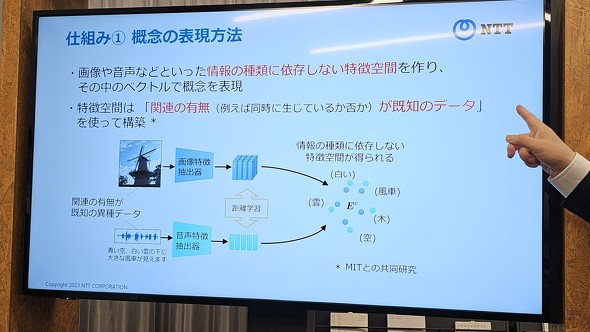

概念を音源分離のフィルターとして使うためには、定量化して数値(ベクトル)にする必要がある。この研究では画像や音声を基に、「白い」「雲」「風車」といった、さまざまな概念を集め、それらをベクトル化して配置した特徴空間を構築した。 似た意味を持つ情報、例えば「ブロッコリーの写真」と「『ミニトマトと合う野菜』と話す音声」は、ベクトルとしては特徴空間上で近くに存在する。特徴空間は、スポーツの実況中継のように、映像と音声に関連性があるかないかが既に分かっているデータを使って構築したという。

音声を解析してテキストに変換する従来の音声認識は、話者が複数いる場合には精度が大きく低下するという課題があったが、音声信号自体を用いずその意味に着目することで、大幅に精度を向上させたという。今後の活用方法としては、サイレンのような重要な音だけを通すノイズキャンセリングヘッドフォンや、心雑音を分離して疾患の早期発見につなげる聴診器などが考えられる。

関連記事

「正解」の喜びを生徒に、個性に合った問題をAIが出題

「正解」の喜びを生徒に、個性に合った問題をAIが出題

NTT コミュニケーション科学基礎研究所が主催するコミュニケーション技術に関するイベント「オープンハウス2023」では、生徒の“個性”に合った問題を出題する教育AIや、磁気作動式ピンディスプレイが展示された。 AIと心電センサーで手術中の医師の感情を可視化

AIと心電センサーで手術中の医師の感情を可視化

横浜国立大学とミルウスは2023年3月31日、心電図センサーとAIを用い、手術中の医師の感情変化を可視化するシステムを開発したと発表した。熟練医師の感情を分析することで、研修医教育に役立つと期待される。 画像診断を支援する人工知能(AI)が医師の負担を軽減

画像診断を支援する人工知能(AI)が医師の負担を軽減

今回は、「(5)医療診断におけるAI活用状況」部分の概要を説明する。 国産初の手術支援ロボット「hinotori」が医療の進化を促す

国産初の手術支援ロボット「hinotori」が医療の進化を促す

今回は、「手術支援ロボット」(2.3.2.1)から「(2)手術支援ロボットの動向」部分の概要を取り上げる。国産初の手術支援ロボット「hinotori」について説明する。 瞳孔インタフェースの新方式で簡易BMIの実現へ、鳥取大

瞳孔インタフェースの新方式で簡易BMIの実現へ、鳥取大

鳥取大学工学部 制御・ロボティクス研究室は2023年1月6日、対光反射減少を利用した意思疎通システムにおいて、左右の目に異なる刺激を投影することで一度に提示可能な刺激パターンを増加させる新方式を提案したと発表した。 実現に向け進む人間型ロボットの現状と課題

実現に向け進む人間型ロボットの現状と課題

人間に酷似した外見や動きを実現する、ヒューマノイドロボット(人間型ロボット)は、ここ数十年間で大きな進展を遂げてきたが、現在もまだ数々の重要な問題や課題を抱えている。

Copyright © ITmedia, Inc. All Rights Reserved.

Special ContentsPR

特別協賛PR

スポンサーからのお知らせPR

Special ContentsPR

Pickup ContentsPR

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- 村田製作所は増収減益、米Resonantのれん438億円減損

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

Special SitePR

あなたにおすすめの記事PR