NVIDIA、次世代AIプラットフォーム「Rubin」発表 26年後半から提供予定:CES 2026で発表

NVIDIAは2026年1月5日(米国時間)、「CES 2026」において、次世代AIプラットフォーム「NVIDIA Rubin」を発表した。新設計のチップ6個で構成され、5個の最新世代技術によって、推論トークンコストを10分の1、MoEトレーニング使用GPUを4分の1に削減できるという。

推論トークンコストを10分の1、MoEトレーニング使用GPUを4分の1に削減

NVIDIAは2026年1月5日(米国時間)、「CES 2026」(2026年1月6〜9日、米国ネバダ州ラスベガス)において、次世代AIプラットフォーム「NVIDIA Rubin」(以下、Rubin)を発表した。

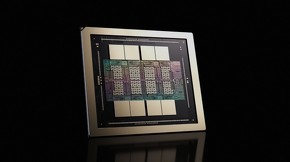

本製品は、「Vera CPU」「Rubin GPU」「NVLink 6 スイッチ」「ConnectX-9 SuperNIC」「BlueField-4 DPU」「Spectrum-6イーサネットスイッチ」という新設計のチップ6個で構成される。

大規模AIファクトリー向けCPUで最も電力効率に優れるというVera CPUに加え、第6世代NVLinkインターコネクトテクノロジー、第3世代Transformer Engine、第3世代Confidential Computing、第2世代RAS Engineという5個の最新世代技術によって、「NVIDIA Blackwell」プラットフォームと比べ、推論トークンを最大10分の1のコストで提供し、MoE(Mixture of Experts)モデルのトレーニングに必要なGPU数を4分の1に削減できるという。

推論コンテキストをギガスケールで拡張するために設計されたという、次世代のAIネイティブストレージインフラ「NVIDIA Inference Context Memory Storage Platform」を導入する。BlueField-4 DPUの搭載により、AIインフラ全体でKVキャッシュデータを効率的に共有および再利用することが可能。応答性とスループットが向上し、エージェント型AIの予測可能で電力効率に優れたスケーリングができるとする。

またBlueField-4 DPUでは、システムレベルのトラストアーキテクチャ「ASTRA(Advanced Secure Trusted Resource Architecture)」も導入している。

Spectrum-6イーサネットスイッチシステムは、従来の方法と比較して信頼性を10倍、稼働時間を5倍に向上させつつ、5倍の電力効率を実現したという。

2026年後半からRubinベース製品の提供開始予定

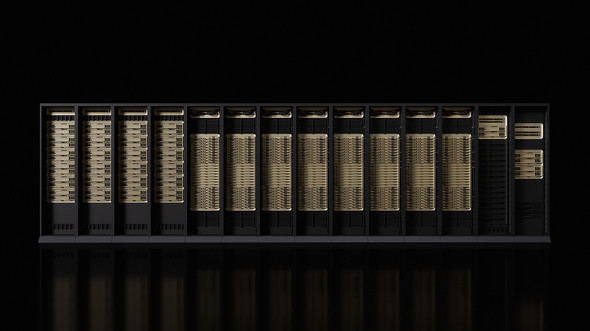

Rubinプラットフォームは、72個のRubin GPU、36個のVera CPUなどを搭載するラックスケールソリューション「Vera Rubin NVL72」と、8個のRubin GPUをNVLinkで接続するためのサーバボードシステム「HGX Rubin NVL8」で提供される。

すでに量産段階に入っていて、2026年後半から、パートナーによるRubinベース製品の提供が始まる予定だ。Vera Rubinベースのインスタンスを最初に展開するクラウドプロバイダーには、AWS(Amazon Web Service)やGoogle Cloud、Microsoft、OCI、CoreWeave、Lambda、Nebius、Nscaleなどが含まれる。

NVIDIAの創業者兼CEOのJensen Huang氏は「トレーニングと推論の両方におけるAIコンピューティングの需要が急増している中、Rubinは絶好なタイミングで登場した。新世代のAIスーパーコンピュータを年次サイクルで提供し、6チップにわたる緊密な協調設計により、RubinはAIの次のフロンティアに向けて大きな飛躍を遂げる」とコメントしている。

関連記事

「SDV開発の促進役」目指すルネサス 最新R-CarのデモをCESで初公開

「SDV開発の促進役」目指すルネサス 最新R-CarのデモをCESで初公開

ルネサス エレクトロニクスは「CES 2026」で、ハイエンドの第5世代車載SoC(System on Chip)「R-Car X5H」を用いたマルチドメインデモを初めて公開した。2025年半ばに出荷を開始したR-Car X5Hのサンプル品を搭載した評価ボードを用いて、先進運転支援システム(ADAS)や車載インフォテインメント(IVI)用のさまざまなソフトウェアが同時に動作する様子を披露した。 NVIDIA「フィジカルAIのブレークスルー到来」 CESに新型ロボ多数登場

NVIDIA「フィジカルAIのブレークスルー到来」 CESに新型ロボ多数登場

NVIDIAは2026年1月5日(米国時間)、「CES 2026」において、フィジカルAI向けの新オープンモデルやフレームワーク、AIインフラを発表した。同時にグローバルパートナー企業各社が、NVIDIAのロボティクス技術を活用したロボット、自律マシンを公開している。 AIグラス向けに新型超低消費電力DSPマイコンを発表、TDK

AIグラス向けに新型超低消費電力DSPマイコンを発表、TDK

TDKは、AIグラス向けのシステムソリューション事業を展開するため、「TDK AIsight」を本格的に立ち上げるとともに、TDK AIsightが開発したAIグラス向けマイクロプロセッサ「SED0112」のサンプル出荷を始めた。 Intel、初の18Aプロセス採用「Core Ultraシリーズ3」を正式発表

Intel、初の18Aプロセス採用「Core Ultraシリーズ3」を正式発表

Intelは2026年1月5日(米国時間)、「CES 2026」においてIntel 18Aプロセス技術を初採用した「Intel Core Ultraシリーズ3プロセッサ」を正式発表した。 ソニー・ホンダモビリティが次世代「AFEELA」を初公開、28年以降に米国投入へ

ソニー・ホンダモビリティが次世代「AFEELA」を初公開、28年以降に米国投入へ

ソニー・ホンダモビリティは「CES 2026」に先駆けて開催したプレスカンファレンスで、「AFEELA 1」のプリプロダクションモデル(先行量産車)と次世代モデルのプロトタイプ「AFEELA Prototype 2026」を公開した。AFEELA Prototype 2026をベースにした新モデルは、2028年以降に米国で発売予定だという。複数の日系メディアによる合同インタビューでは、クルマの“基礎体力”となるハードウェア/半導体の進化に対する期待も寄せた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

- 村田製作所“社内ベンチャー”発、産業版スマートプラグに期待