GoogleのAI用チップ、Intelの性能を上回ると報告:機械学習に特化した「TPU」

Googleが2016年に発表した、機械学習の演算に特化したアクセラレータチップ「TPU(Tensor Processing Unit)」が、IntelのCPUやNVIDIAのGPUの性能を上回ったという。Googleが報告した。

IntelとNVIDIAのチップを上回ると報告

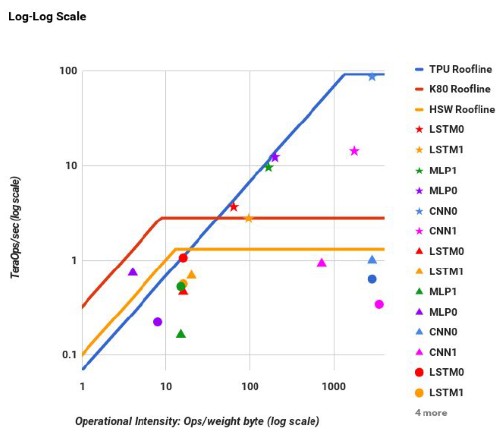

Googleによると、同社の人工知能(AI)向けアクセラレータチップ「Tensor Processing Unit(以下、TPU)」が、機械学習のテストでIntelのサーバ向けプロセッサ「Xeon」とNVIDIA製のGPUを1桁以上も上回る結果を出したという。17ページにわたる論文は、TPUとベンチマークについて深く掘り下げる内容になっている。具体的には、TPUが、上記のIntelおよびNVIDIAのチップに比べて15倍の処理速度を実現し、1ワット当たりの処理性能は30倍となっていることが示されている。

GoogleがTPUを発表したのは2016年5月のことだ。TPUは、自社のデータセンター向けサーバ上の幅広いアプリケーションにおける推論プロセスを加速するために開発されたという。

Googleは現在、2017年6月に開催されるコンピュータアーキテクチャ関連のカンファレンスで発表予定の論文の中で、TPUの詳細を初めて明らかにしている。

論文では、TPUの他、Googleが取り組むさまざまなニューラルネットワークの開発について述べられている。また、機械学習についてエンジニアが学ぶべきことはたくさんあると示唆している。

著名なハードウェアエンジニアで、TPUの開発に関わった70人以上のエンジニアから成るチームを率いたNorman P. Jouppi氏は、「われわれは優秀なエンジニアを必要としている。そのため、彼らに、私たちの仕事の質がいかに高いかを知ってもらいたかった。さらに、クラウド分野の顧客に、当社の能力を知っていただきたいと思っている」と述べている。

米カリフォルニア大学バークレー校の元教授で、ベテランのプロセッサアーキテクトでもあるDavid Patterson氏も、TPU開発プロジェクトに貢献した1人だ。同氏は2017年4月5日(米国時間)にシリコンバレーで開催されたエンジニア向けのシンポジウム「NAE Regional Meeting」で、当該論文を発表したという。

TPUは、既にGoogleのデータセンターで使われている。ただしJouppi氏は、TPUがどのくらいの規模で使われているのか、今後どの程度拡張していくのかなどについて、詳細を明らかにすることは避けた。

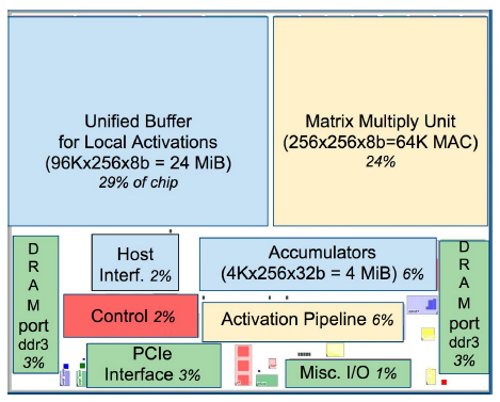

TPUは28nmプロセスを採用したチップで、動作周波数は700MHzである。Googleが20215年にリリースしたオープンソースのアルゴリズム「TensorFlow」を加速するために開発された。主論理ユニットには8ビットの乗算累算ユニットが6万5536個、24Mバイトのキャッシュが搭載されていて、92TOPS(Tera Operations Per Second)の処理性能を実現するという。

Googleの機械学習処理を用いた、2015年のベンチマークでは、TPUは、Intelのサーバ向けCPU「Haswell」(開発コード名)やNVIDIAのGPU「K80」に比べ、15〜30倍、処理が高速だったという。それだけでなく、1ワット当たりの性能は30〜80倍としている。

2015年のベンチマークテストでは、Intelの「Haswell E5-2699 v3」(22nmプロセス、18コア)が使われた。同チップの動作周波数は2.3GHzで、TDP(熱設計電力)は145W。NVIDIAのK80のTDPは150Wで、動作周波数は最大875MHzである。

【翻訳:青山麻由子、編集:EE Times Japan】

関連記事

GoogleからAI用プロセッサ「TPU」が登場

GoogleからAI用プロセッサ「TPU」が登場

Googleが、人工知能(AI)に向けたアクセラレータチップ「Tensor Processing Unit(TPU)」を独自開発したことを明らかにした。同社が2015年にリリースした、オープンソースのアルゴリズム「TensorFlow」に対応するという。 ARMの新ベクトル命令「SVE」、ポスト京に採用へ

ARMの新ベクトル命令「SVE」、ポスト京に採用へ

米国で開催された「Hot Chips 28」において、ARMが新しいベクトル命令「SVE(Scalable Vector Extensions)」を発表した。富士通が、2020年を目標に開発しているポスト「京」スーパーコンピュータに採用されることが決まっている。 Intelが10nmプロセスの詳細を明らかに

Intelが10nmプロセスの詳細を明らかに

Intelは2017年に10nmチップ製造を開始する予定だ。さらに、22nmの低電力FinFET(FinFET low power、以下22nm FFL)プロセスも発表した。GLOBALFOUNDRIESなどが手掛けるFD-SOI(完全空乏型シリコン・オン・インシュレーター)に真っ向から挑み、ファウンドリービジネスで競い合う。 Google CarにもV2V技術は不可欠だ

Google CarにもV2V技術は不可欠だ

このほど、Google(グーグル)とDelphi Automotive(デルファイ)の自動運転車が路上で、衝突寸前のニアミスを起こしていたことが判明した。人為的ミスの存在しない自動運転車同士のニアミスの一因は、V2V(車車間)通信技術を搭載していなかった点にあるだろう。 IntelによるMobileye買収、アナリストの反応は

IntelによるMobileye買収、アナリストの反応は

IntelがMobileyeを買収することで合意したと発表した。自動運転車向けのコンピュータビジョン技術において既に同分野をけん引する存在であるMobileyeが買収されるというこの発表は、業界を驚かせた。調査会社のアナリストなど、業界の専門家はこの動きをどう見ているのだろうか。 Uberの自動運転車がアリゾナ州で横転事故

Uberの自動運転車がアリゾナ州で横転事故

Uberの自動運転車が横転する事故が発生した。数々の疑問が浮かんでくるが、それを解明するにはUber側が、事故当時のデータを、さらに開示するのを待つ必要があるだろう。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- TIがSilicon Labsを75億ドルで買収する理由

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- TSMCが熊本第2工場で3nm導入へ CEOが表明

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

- 「何でもできるが誰にも使えない」――自作MASが突きつけた現実

- ソニー半導体、3Qは過去最高 通期予想もさらに上方修正

TPUの構成。MACアレイと24Mバイトのキャッシュが大半を占める

TPUの構成。MACアレイと24Mバイトのキャッシュが大半を占める TPUの構成。MACアレイと24Mバイトのキャッシュが大半を占める

TPUの構成。MACアレイと24Mバイトのキャッシュが大半を占める