新時代到来! ヘテロジニアス・コンピューティング最新動向【前編】:プロセッサ/マイコン(4/4 ページ)

HSAのキモとなるhUMAとhQ

HSAプログラミングモデル実現にあたっては、ハードウェアレベルの対応も不可欠になる。そこで鍵となるのが、“hUMA”と“hQ”と呼ばれるHSA機能だ。

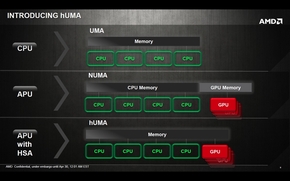

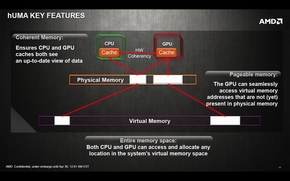

“hUMA”(heterogeneous Uniform Memory Access)は、CPUとGPUがメモリアドレスを共有し、CPUとGPUそれぞれのメモリにページマッピングできるようになる。これにより、CPU側のメモリデータをGPU側のメモリにコピーすることなく読めるようになり、その逆にGPU側のメモリデータにCPUがアクセスすることもできるようになる。

また、hUMAでは、GPUコアがCPUコアとハードウェアレベルでメモリコヒーレンシを取ることで、より効率的にもう一方のメモリにアクセスできるようになる。この他、hUMAではCPUとGPUのプロセス間通信を行うシグナリングについても定義されている。

左=現状のメモリアーキテクチャと、hUMAの違い。右=CPUとGPUがメモリアドレスを共有し、CPUとGPUそれぞれのメモリにページマッピングできるようになる。これにより、CPU側のメモリデータをGPU側のメモリにコピーすることなく読めるようになり、その逆も可能になる (クリックで拡大)

左=現状のメモリアーキテクチャと、hUMAの違い。右=CPUとGPUがメモリアドレスを共有し、CPUとGPUそれぞれのメモリにページマッピングできるようになる。これにより、CPU側のメモリデータをGPU側のメモリにコピーすることなく読めるようになり、その逆も可能になる (クリックで拡大)

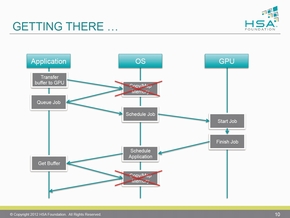

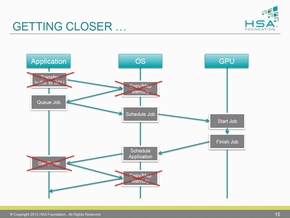

左=hUMAのサポートにより、アプリケーションがGPUを利用するハードルを一段低くすることが可能になる。右=さらにGPUとCPUのプロセス間通信を実現することで、命令バッファの転送なども不要になり、アプリケーションをGPUに近いところで実行できるようになる (クリックで拡大)

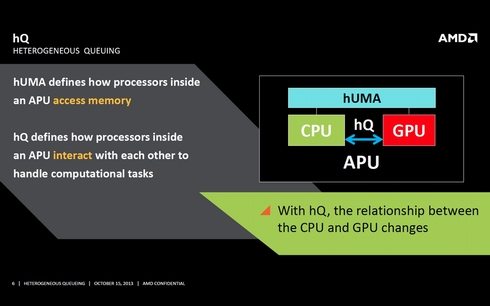

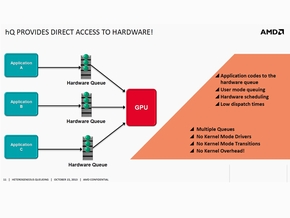

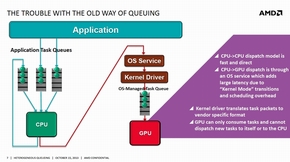

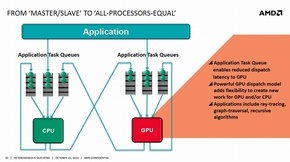

左=hUMAのサポートにより、アプリケーションがGPUを利用するハードルを一段低くすることが可能になる。右=さらにGPUとCPUのプロセス間通信を実現することで、命令バッファの転送なども不要になり、アプリケーションをGPUに近いところで実行できるようになる (クリックで拡大)一方、“hQ”(heterogeneous Queing)は、OSを介さずにユーザーモードでGPUのキュー(待ち行列)に演算処理のパケットを発行できるようにする仕組みだ。現在、GPUで汎用演算処理を行うためには、アプリケーションは、まずOSのAPIを通じてグラフィックスドライバ経由でGPUにアクセスすることになり、複雑かつオーバーヘッドが大きくなるという欠点がある。

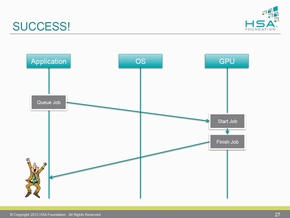

これに対し、hQでは、HSAランタイムを介して共有メモリアドレス空間にHSAキューを生成し、OSを介することなくユーザーモードでGPUで実行するパケットを発行することができるようになるため、あたかもGPUをCPUコアと同じように扱えるようにできる。また、このHSAキューは、HSAランタイムを介してCPUにも利用できるため、CPUとGPUのシームレスな連係を可能にする。HSAファウンデーションでは、このhQのパケットフォーマットやプロトコル、キューイング言語を定義し、アプリケーションが容易にGPUを並列演算処理に利用できるようにしている。

そして、これらの機能にハードウェアレベルで対応したのが、2014年1月14日に正式発表された最新のAMD Aシリーズプロセッサ“Kaveri”というわけだ。

左=現在、アプリケーションがGPUを利用しようとすると、OSのAPIを通じてグラフィックスドライバ経由でGPUにアクセスすることになり、複雑かつオーバーヘッドが大きくなるという欠点がある。右=hQでは、HSAランタイムを介して共有メモリアドレス空間にHSAキューを生成し、OSを介することなくユーザーモードでGPUで実行するパケットを発行することができるようになる (クリックで拡大)

左=現在、アプリケーションがGPUを利用しようとすると、OSのAPIを通じてグラフィックスドライバ経由でGPUにアクセスすることになり、複雑かつオーバーヘッドが大きくなるという欠点がある。右=hQでは、HSAランタイムを介して共有メモリアドレス空間にHSAキューを生成し、OSを介することなくユーザーモードでGPUで実行するパケットを発行することができるようになる (クリックで拡大)- UIの表現力向上で機器の新たな価値を創造、ルネサスのHMI用ASSP

- ルネサス、家電/産機の普及モデルでインバータ制御を実現するFPU搭載低価格マイコン

- RL78マイコンが3倍速くなるコンパイラを発表――ルネサス

- MSP430の系譜を継ぐ、低消費電力重視のARM Cortex-M4マイコン「MSP432」を発表

- ギガビットイーサネット対応を5ドル以下で実現、16コア搭載マイコン

- ルネサス、28nm世代混載フラッシュ技術を改良――順調に進む次世代車載マイコン開発

- 「Snapdragon」はさらに高性能に、64ビットCortex-A72を搭載

- グラフィックス表示、ゲージ制御、機能安全を1チップで実現、ルネサスの32ビットマイコン

- グラフィックス処理とボイス制御に対応、HMI用Cortex-M4搭載マイコン

- ルネサス、2015年度内にSOTB採用マイコンを製品化へ――消費電力1/10以下、0.4V駆動品も可能に

関連キーワード

GPU | CPU | アプリケーション | Bulldozer | AMD | Kaveri | APU | 性能 | 実行環境 | API | ARM | 開発コード名 | プログラミング | AMD Fusion | プラットフォーム | 整備 | プログラム | ソフトウェア | Llano | PC | 開発基盤 | フレームワーク | GPUコンピューティング | Imagination Technologies | PCI Express | 標準化 | 仮想メモリ | x86 | Brazos | 開発環境 | プロセッサ/マイコン(エレクトロニクス) | 電力効率 | GPGPU | 最適化 | 推進団体

関連記事

AMDのプロセッサ「Kaveri」、ベンチマーク性能でインテルのCore-i5を上回る

AMDのプロセッサ「Kaveri」、ベンチマーク性能でインテルのCore-i5を上回る

AMDが新型のプロセッサ「Kaveri」を発表した。ベンチマークテストでは、インテルのプロセッサ「Core i5-4670K」を上回る性能を達成したという。 サーバ用CPU市場に挑むAMDとARMの思惑――ゲーム機の成功モデルをサーバでも

サーバ用CPU市場に挑むAMDとARMの思惑――ゲーム機の成功モデルをサーバでも

AMDは、ARMの64ビットコアを採用したサーバ向けCPU「Seattle(開発コードネーム)」を、2014年第2四半期にサンプル出荷することを明らかにした。AMDは、ARMサーバ市場でシェアを伸ばすために、同社がゲーム機市場で成功したときのモデルを持ち込もうとしている。すなわち、カスタムSoCの開発だ。Seattleを汎用品として市場に投入したあとは、そうしたカスタムSoCの開発を進める予定としている。 AMD、モバイル向けに新型プロセッサを発表

AMD、モバイル向けに新型プロセッサを発表

モバイル機器向けの製品開発に力を入れているAMDが、2014年に出荷を開始する予定のプロセッサ2品種を発表した。CPUコア「Puma」を搭載し、Windows 8.1の新機能「InstantGo」をサポートする。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

HSAのアーキテクチャを説明するAMDのフィル・ロジェース氏(フェロー)。同氏はHSAファウンデーションの議長も務める

HSAのアーキテクチャを説明するAMDのフィル・ロジェース氏(フェロー)。同氏はHSAファウンデーションの議長も務める