NVIDIAの「H200」GPUに載る Micronが24GB HBM3Eの量産を開始:36GB版も間もなくサンプル出荷へ

Micron Technologyが、8層積層の24GバイトHBM3E(広帯域幅メモリ3E)の量産を開始した。1βプロセスを適用する。2024年第2四半期に出荷を開始するNVIDIAの「H200 Tensorコア GPU」に搭載されるという。

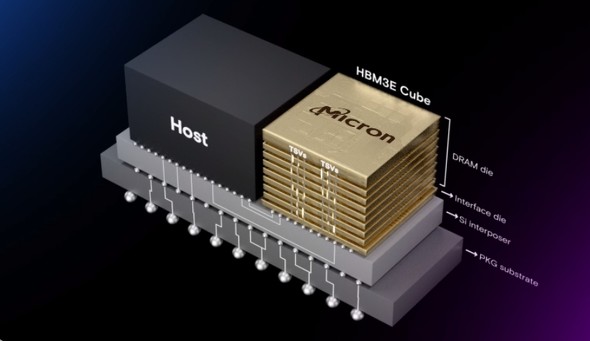

Micron Technology(以下、Micron)は2024年2月26日(米国時間)、8層積層の24GバイトHBM3E(広帯域幅メモリ3E)の量産を開始したと発表した。競合製品に比べて消費電力を約30%削減したという。8層を積層した24GバイトのHBM3Eで、2024年第2四半期に出荷を開始するNVIDIAの「H200 Tensorコア GPU」に搭載される。

量産を開始したHBM3Eは、AI(人工知能)ワークロードの多様化でメモリに求められる性能を実現すべく、高速なメモリ帯域幅と低い消費電力、大規模なニューラルネットワークの学習でも推論でも活用できる拡張性を備えているとする。1ピン当たり9.2Gbps(ギガビット/秒)以上の高速化により、1.2TB/s(テラバイト/秒)のメモリ帯域幅を実現。AIアクセラレーターやスーパーコンピュータ、データセンターで求められる高速なデータアクセスに対応できるとした。

このHBM3Eの製造には、Micronの1βプロセスが適用される。同社の上席副社長 兼 最高事業責任者を務めるSumit Sadana氏は、「AIワークロードはメモリの帯域幅と容量に大きく依存する。HBM3E/HBM4の技術ロードマップおよび、AIアプリケーションに向けた包括的なDRAM/NAND型フラッシュメモリのポートフォリオにより、MicronはAIの普及加速をサポートするポジションにある」と述べた。

なおMicronは、1.2TB/sを超えるスピードと、より高い電力効率を実現する12層積層の36GバイトHBM3Eのサンプル出荷を2024年3月にも開始する予定だ。

生成AIの需要増に伴い、HBM市場は急速に拡大している。Micronが8層の24Gバイト HBM3Eを発表した翌日(2024年2月27日)には、Samsung Electronicsが「業界初」(同社)とする12層の36Gバイト HBM3Eを開発したと発表した。さらに、時事通信は2024年3月1日、SK hynixがHBMの製造でキオクシアに協業案を打診していることが明らかになったと報じた。

関連記事

Samsungが、「業界初」12層の36GB HBM3E DRAMを開発

Samsungが、「業界初」12層の36GB HBM3E DRAMを開発

Samsung Electronicsが、「業界初」(同社)となる12層の36Gバイト(GB)HBM3E DRAM製品「HBM3E 12H」を開発した。既にサンプル出荷を行っていて、2024年前半の量産開始を予定している。 NVIDIA、HBM3eメモリ採用の次世代GH200を発表

NVIDIA、HBM3eメモリ採用の次世代GH200を発表

NVIDIAは、生成AI用途に向けた次世代のコンピューティングプラットフォーム「NVIDIA GH200 Grace Hopper Superchip」を発表した。広帯域幅メモリの最新バージョンである「HBM3e」を採用した。現行製品に比べ、最大で3.5倍のメモリ容量と3倍の帯域幅を実現できるという。 超高速DRAM技術「HBM」の基礎

超高速DRAM技術「HBM」の基礎

今回は、「3次元(3D)技術はDRAM開発にとって援軍ではあるが救世主ではない」という事実とともに、3D技術を用いた超高速DRAM「HBM」とはどのようなDRAMなのかを紹介していく。 DDR4とHBMの長所と短所

DDR4とHBMの長所と短所

今回は、HBM(High Bandwidth Memory)とDDR4 DRAMを、データ転送速度やパッケージングなどの点から比較してみる。後半は、埋め込みDRAM(eDRAM)の説明に入る。ARM ReserchのRob Aitken氏は、eDRAMが「ニッチな市場にとどまる」と予想しているが、それはなぜだろうか。 経産省、Micron広島工場に最大1920億円を助成

経産省、Micron広島工場に最大1920億円を助成

Micron Technologyの広島工場(広島県東広島市)は、経済産業省より最大1920億円の助成金を受け取ることに決まったと発表した。EUV(極端紫外線)露光を用いた1γ(ガンマ)DRAMの生産や、次世代広帯域メモリ(HBM4)の研究開発などに充てる。 CXLはデータセンターの「救世主」となるのか

CXLはデータセンターの「救世主」となるのか

AI(人工知能)の普及でデータ量が爆発的に増大し、データセンターにかかる負担が増加する中、その課題解決の鍵はCXL(Compute Express Link)インタフェースが握っている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか