伝導液冷の強制空冷に対する優位性:福田昭のデバイス通信(480) AIサーバの放熱技術(13)

今回は、今後普及するとみられる伝導液冷を解説する。強制空冷に対し、電力コストやインフラ整備の点で優位性がある。

データセンターの冷却に必要な電力コストは約6割に低下

サーバやデータセンターなどの放熱技術に注目が集まっている。演算処理を担うGPUとCPUの最大消費電力(熱設計電力(TDP))が増加しつつあることで、効率の高い放熱技術が強く求められるようになってきた。

そこで本コラムでは、サーバやデータセンターなどを支える最新の放熱技術を第468回から、シリーズで説明している。前々回は純水や冷却液などの液体を使ってラックマウントサーバを冷却する「液体冷却(液冷)システム」の概要を、前回は間接・伝導方式の液体冷却技術(伝導液冷技術)の構成を述べた。

今回は従来のラックマウントサーバおよびデータセンターの放熱に使われてきた強制空冷に対する、これから普及するとみられる伝導液冷の優位性をご説明する。

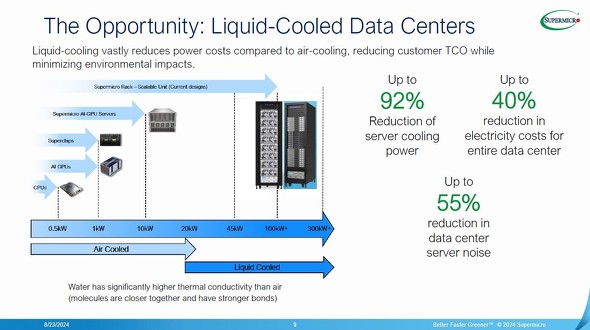

始めは放熱に要する電力コストである。大手サーバベンダーのSupermicroによると、強制空冷のコストを100%として相対値で比較するとサーバユニットの放熱に要する電力のコストはわずか8%で済む。データセンター全体でも、放熱に要する電力のコストは60%にとどまるとする。1000台のGPUサーバユニット(1台に8個のGPUを搭載)で構成されるデータセンターで5年間に節約できる電力コストは、6000万米ドルに達するとSupermicroは主張する(電力代金は0.18米ドル/kWhと仮定)。

また重要なのが、放熱システムが発する騒音である。強制空冷は冷却用送風ファンの騒音が無視できない。伝導液冷だとサーバが発生する騒音は強制空冷の約45%に減少する。

伝導液冷の強制空冷に対する優位性。許容可能な消費電力がラック当たりで100kWと拡大するほか、放熱に要する電力コストの削減、サーバが発する騒音の低減が見込める[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドから

伝導液冷の強制空冷に対する優位性。許容可能な消費電力がラック当たりで100kWと拡大するほか、放熱に要する電力コストの削減、サーバが発する騒音の低減が見込める[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドからサーバを冷却するインフラが簡素に

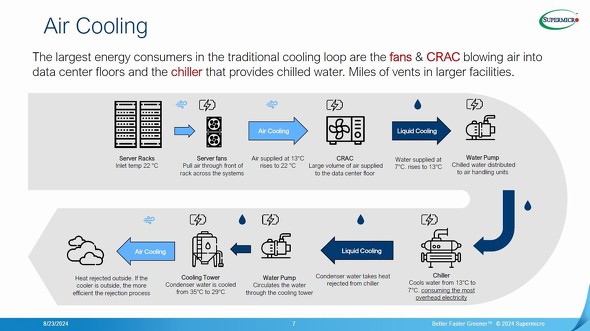

伝導液冷では、強制空冷に比べて放熱・冷却のインフラが簡素になるメリットも見逃せない。強制空冷ではサーバユニットを冷却する送風ファン、サーバによって温められた空気の温度を冷却水によって下げる「空調機(CRAC:Computer Room Air Conditioner、「クラック」とも呼ぶ)」、空調機(CRAC)によって温められた冷却水を冷やす「冷却水循環器(チラー:Chiller)」などが必要となる。特に「チラー」は強制空冷のインフラで最も電力を費やす熱交換器だとされる。

強制空冷の放熱・冷却インフラ[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドから

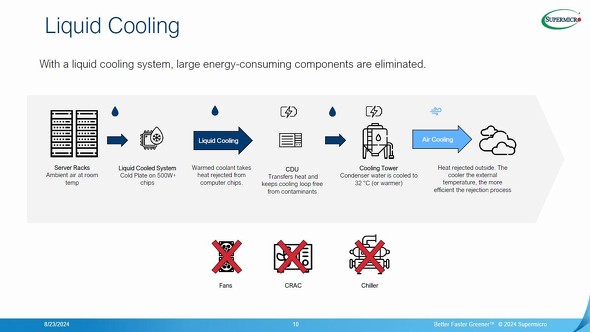

強制空冷の放熱・冷却インフラ[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドから伝導液冷では、送風ファン、CRAC、チラーが不要となる。送風ファンはゼロにならなくても、強制空冷に比べるとはるかに低い能力のファンで済む。CRACとチラー、特にチラーが不要になることは電力コストの削減に効く。

伝導液冷は初期コスト(導入コスト)が極めて高いというイメージを持たれやすい。しかし実際には、強制空冷では必須だったいくつかの熱交換器を省ける。新しく伝導液冷のデータセンターを構築するのであれば、導入コストはあまり高くならない。そもそもラック当たりで消費電力が100kW以上に達するGPU主体のAIサーバは、強制空冷による放熱は困難だろう。

伝導液冷の放熱・冷却インフラ[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドから

伝導液冷の放熱・冷却インフラ[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドからその他、サーバルームに配置可能なラックマウントサーバの台数(単位床面積当たり)が強制空冷に比べて増加するというメリットもある。ラック間の熱干渉が原理的には存在しないからだ。

⇒「福田昭のデバイス通信」連載バックナンバー一覧

関連記事

ラックサーバのデータセンターを支える空冷技術

ラックサーバのデータセンターを支える空冷技術

データセンターの放熱/冷却システムの詳細を解説する。まずは空冷方式を取り上げる。 サーバの主なフォームファクター

サーバの主なフォームファクター

今回は、サーバの主なフォームファクター(外形の形状と寸法)を解説する。大きく分けて、3つのフォームファクターがある。 放熱と冷却の基本的な技術

放熱と冷却の基本的な技術

今回は、放熱と冷却の基本的な技術を解説する。 熱に関する基礎知識

熱に関する基礎知識

「Hot Chips 2024」の技術講座(チュートリアル)のテーマは放熱技術だった。CPU/GPUの消費電力が増加し、サーバやデータセンターの放熱技術に対する注目が集まっているからだ。本シリーズでは、Hot Chips 2024の技術講座などをベースに、最新の放熱技術を解説する。 3端子貫通型フィルタの接続方法と実装レイアウト

3端子貫通型フィルタの接続方法と実装レイアウト

今回は「(2)3端子貫通型フィルタの接続と実装のポイント」の概要を説明する。3端子貫通型フィルタを電源ラインに接続する2つの方法と、それぞれの用途を解説する。 チップ抵抗器の小型化が過度な温度上昇を招く(前編)

チップ抵抗器の小型化が過度な温度上昇を招く(前編)

今回から、第4章第1節第3項「部品実装・設計時の注意点」の概要を説明していく。この項は、「熱設計」「電気性能」などの4つのパートで構成される。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか